在管理Spark项目配置时,主要可以通过以下几种方式1、配置文件管理、2、环境变量管理、3、参数传递管理、4、动态配置管理,从而保证项目运行的稳定性和灵活性。接下来将详细介绍这些方法。

一、配置文件管理

配置文件管理是最常见的配置管理方式,通过将配置信息存储在文件中,可以方便地进行读取和修改。常见的配置文件格式包括Properties、YAML和JSON等。

1.1、Properties文件

Properties文件是Java中常用的配置文件格式,适用于简单的键值对配置。

# example.properties

spark.app.name=MySparkApp

spark.master=local[*]

spark.executor.memory=2g

1.2、YAML文件

YAML文件适用于层次结构较为复杂的配置,并且具有良好的可读性。

# example.yaml

spark:

app:

name: MySparkApp

master: local[*]

executor:

memory: 2g

1.3、JSON文件

JSON文件也适用于层次结构较为复杂的配置,且易于解析和生成。

{

"spark": {

"app": {

"name": "MySparkApp"

},

"master": "local[*]",

"executor": {

"memory": "2g"

}

}

}

二、环境变量管理

通过环境变量管理配置,可以在不同环境中灵活调整配置信息,避免硬编码问题。可以使用Shell脚本或系统环境变量进行配置。

2.1、Shell脚本

export SPARK_APP_NAME=MySparkApp

export SPARK_MASTER=local[*]

export SPARK_EXECUTOR_MEMORY=2g

spark-submit --class com.example.MySparkApp \

--master $SPARK_MASTER \

--conf spark.executor.memory=$SPARK_EXECUTOR_MEMORY \

my-spark-app.jar

2.2、系统环境变量

在操作系统中设置环境变量,例如在Linux系统中,可以在~/.bashrc或/etc/environment文件中进行配置:

export SPARK_APP_NAME=MySparkApp

export SPARK_MASTER=local[*]

export SPARK_EXECUTOR_MEMORY=2g

三、参数传递管理

通过命令行参数传递配置,可以在运行时动态调整配置信息,适用于需要频繁更改配置的场景。

3.1、Spark Submit参数

使用spark-submit提交作业时,可以通过--conf参数传递配置信息:

spark-submit --class com.example.MySparkApp \

--master local[*] \

--conf spark.app.name=MySparkApp \

--conf spark.executor.memory=2g \

my-spark-app.jar

3.2、程序内部参数

在程序内部通过命令行参数接收配置信息:

object MySparkApp {

def main(args: Array[String]): Unit = {

val spark = SparkSession.builder()

.appName(args(0))

.master(args(1))

.config("spark.executor.memory", args(2))

.getOrCreate()

// Your Spark code here

}

}

运行时传递参数:

spark-submit --class com.example.MySparkApp \

my-spark-app.jar MySparkApp local[*] 2g

四、动态配置管理

动态配置管理是一种高级配置管理方式,通过集中化的配置管理平台实现配置的动态调整和实时更新,常见的工具包括Apache Zookeeper、Consul和Spring Cloud Config等。

4.1、Apache Zookeeper

Zookeeper是一个分布式协调服务,可以用于动态配置管理。可以将配置信息存储在Zookeeper中,并在程序中动态读取和更新。

# Set configuration in Zookeeper

zkCli.sh create /spark/config '{"spark.app.name": "MySparkApp", "spark.master": "local[*]", "spark.executor.memory": "2g"}'

在程序中读取配置:

import org.apache.zookeeper.ZooKeeper

object MySparkApp {

def main(args: Array[String]): Unit = {

val zk = new ZooKeeper("localhost:2181", 3000, null)

val configData = zk.getData("/spark/config", false, null)

val configJson = new String(configData)

val config = parseConfig(configJson)

val spark = SparkSession.builder()

.appName(config("spark.app.name"))

.master(config("spark.master"))

.config("spark.executor.memory", config("spark.executor.memory"))

.getOrCreate()

// Your Spark code here

}

def parseConfig(json: String): Map[String, String] = {

// Parse JSON and return configuration map

}

}

4.2、Consul

Consul是一个支持服务发现和配置管理的工具,可以用于动态配置管理。可以将配置信息存储在Consul中,并在程序中动态读取和更新。

# Set configuration in Consul

consul kv put spark/config '{"spark.app.name": "MySparkApp", "spark.master": "local[*]", "spark.executor.memory": "2g"}'

在程序中读取配置:

import com.orbitz.consul.Consul

object MySparkApp {

def main(args: Array[String]): Unit = {

val consul = Consul.builder().build()

val kvClient = consul.keyValueClient()

val configJson = kvClient.getValueAsString("spark/config").get()

val config = parseConfig(configJson)

val spark = SparkSession.builder()

.appName(config("spark.app.name"))

.master(config("spark.master"))

.config("spark.executor.memory", config("spark.executor.memory"))

.getOrCreate()

// Your Spark code here

}

def parseConfig(json: String): Map[String, String] = {

// Parse JSON and return configuration map

}

}

4.3、Spring Cloud Config

Spring Cloud Config是一个支持分布式系统的配置管理工具,可以用于动态配置管理。可以将配置信息存储在Git、SVN等版本控制系统中,并在程序中动态读取和更新。

# application.yml

spring:

cloud:

config:

server:

git:

uri: https://github.com/your-repo/config-repo

search-paths: spark

spark:

app:

name: MySparkApp

master: local[*]

executor:

memory: 2g

在程序中读取配置:

import org.springframework.beans.factory.annotation.Value

import org.springframework.boot.SpringApplication

import org.springframework.boot.autoconfigure.SpringBootApplication

import org.springframework.cloud.context.config.annotation.RefreshScope

@SpringBootApplication

@RefreshScope

class MySparkApp {

@Value("${spark.app.name}")

var appName: String = _

@Value("${spark.master}")

var master: String = _

@Value("${spark.executor.memory}")

var executorMemory: String = _

def main(args: Array[String]): Unit = {

val spark = SparkSession.builder()

.appName(appName)

.master(master)

.config("spark.executor.memory", executorMemory)

.getOrCreate()

// Your Spark code here

}

}

object MySparkApp {

def main(args: Array[String]): Unit = {

SpringApplication.run(classOf[MySparkApp], args: _*)

}

}

总结

通过以上四种方式,可以灵活高效地管理Spark项目配置:

- 配置文件管理:适用于配置较为静态的场景,便于维护和版本控制。

- 环境变量管理:适用于不同环境的配置管理,避免硬编码问题。

- 参数传递管理:适用于需要频繁更改配置的场景,灵活性高。

- 动态配置管理:适用于大规模分布式系统,实现配置的集中化管理和动态调整。

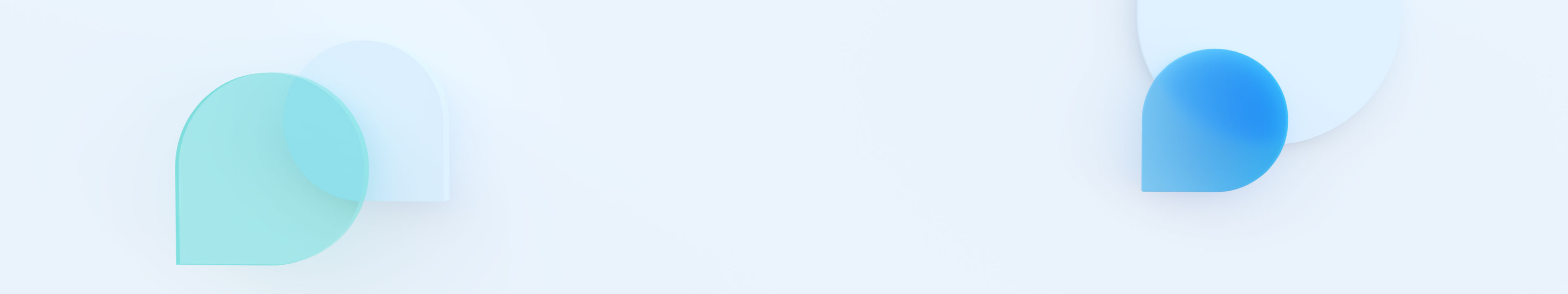

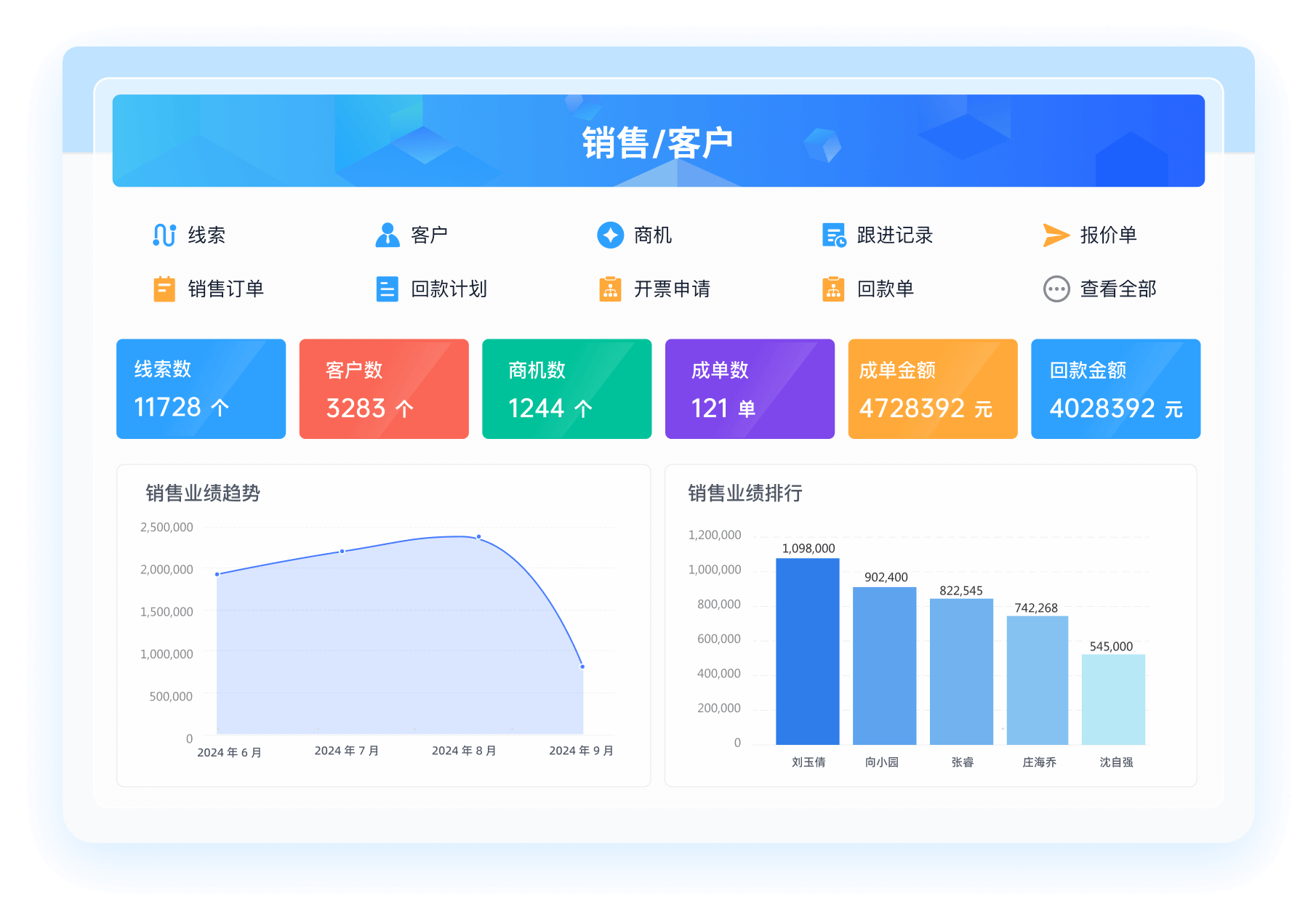

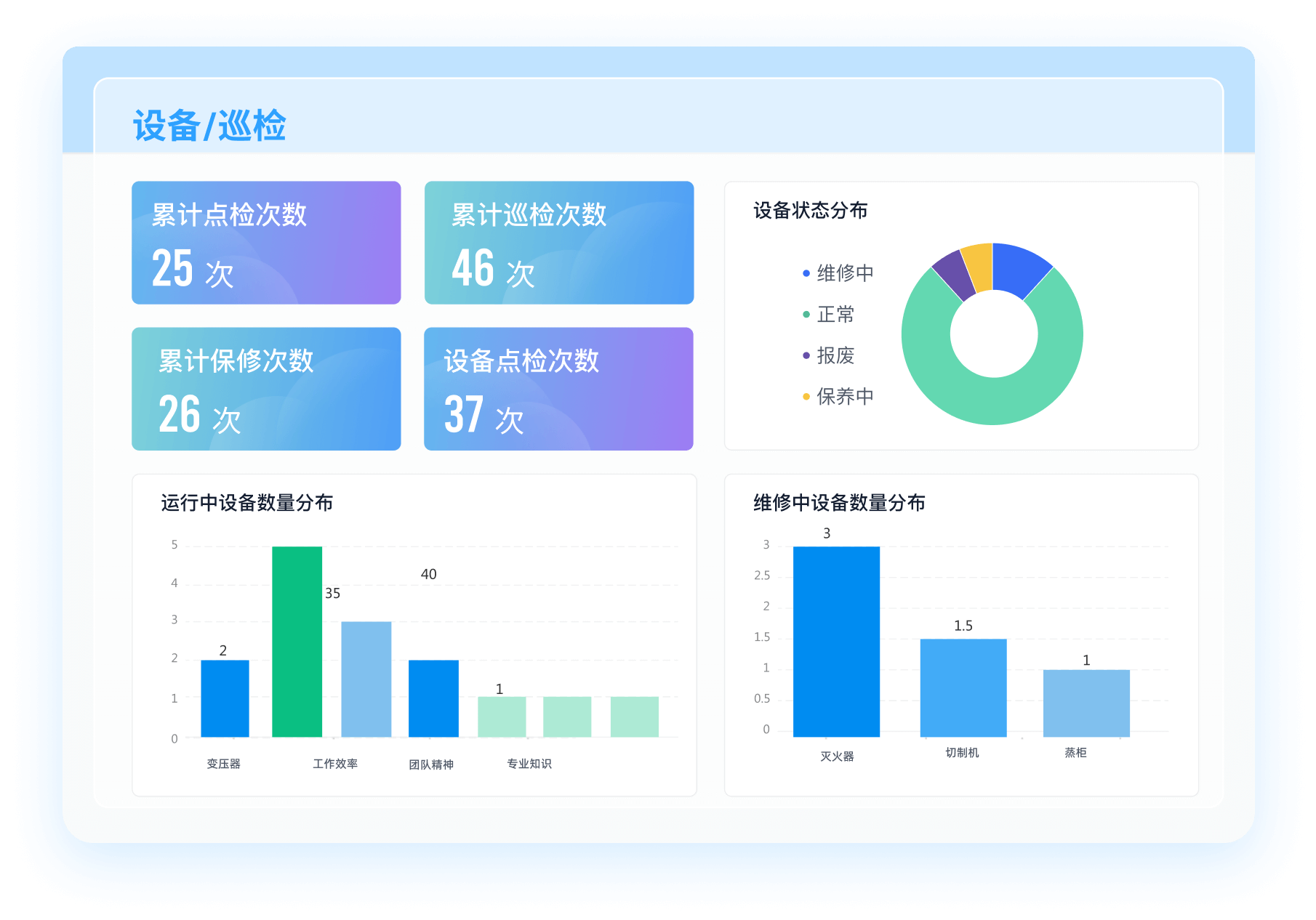

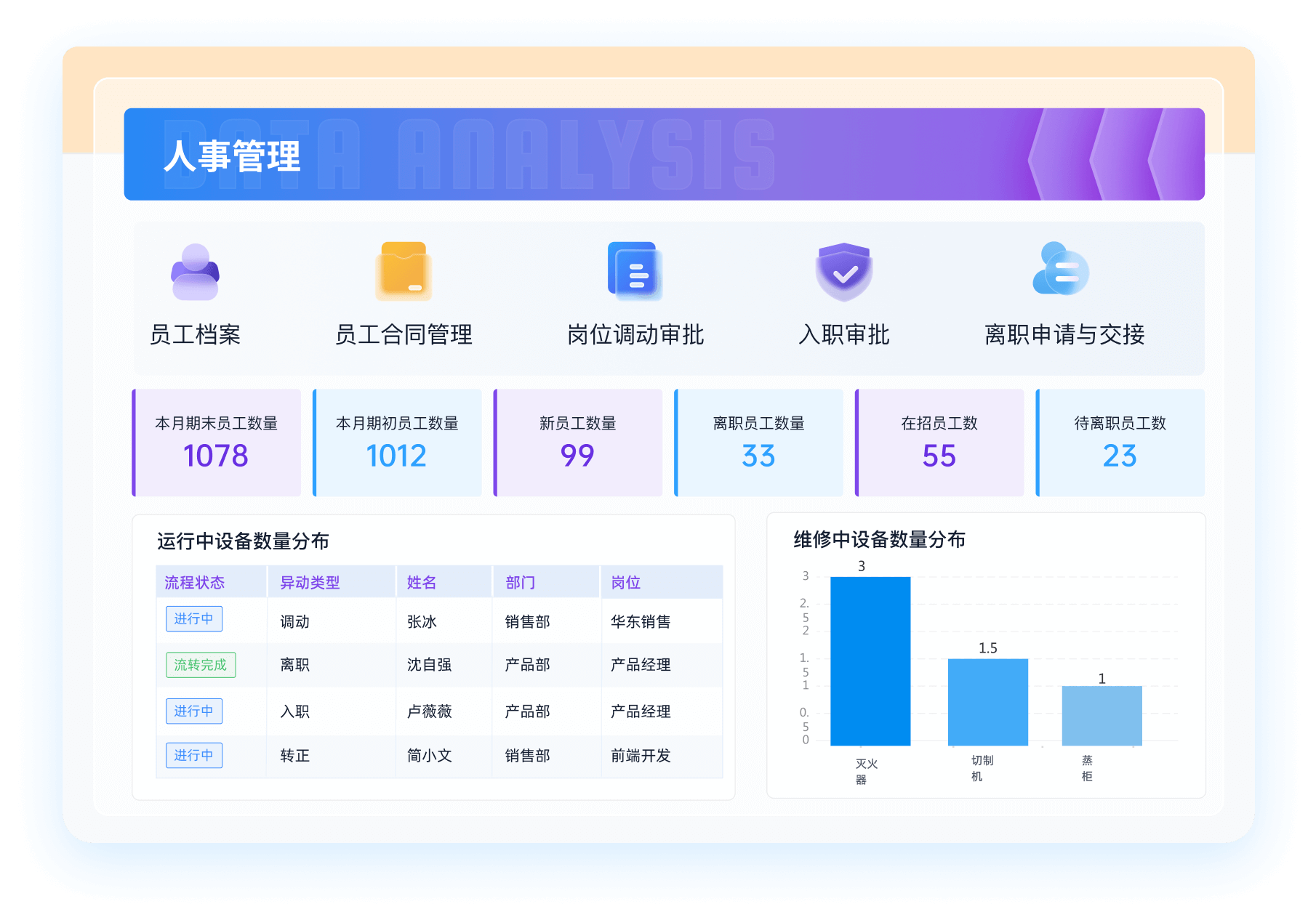

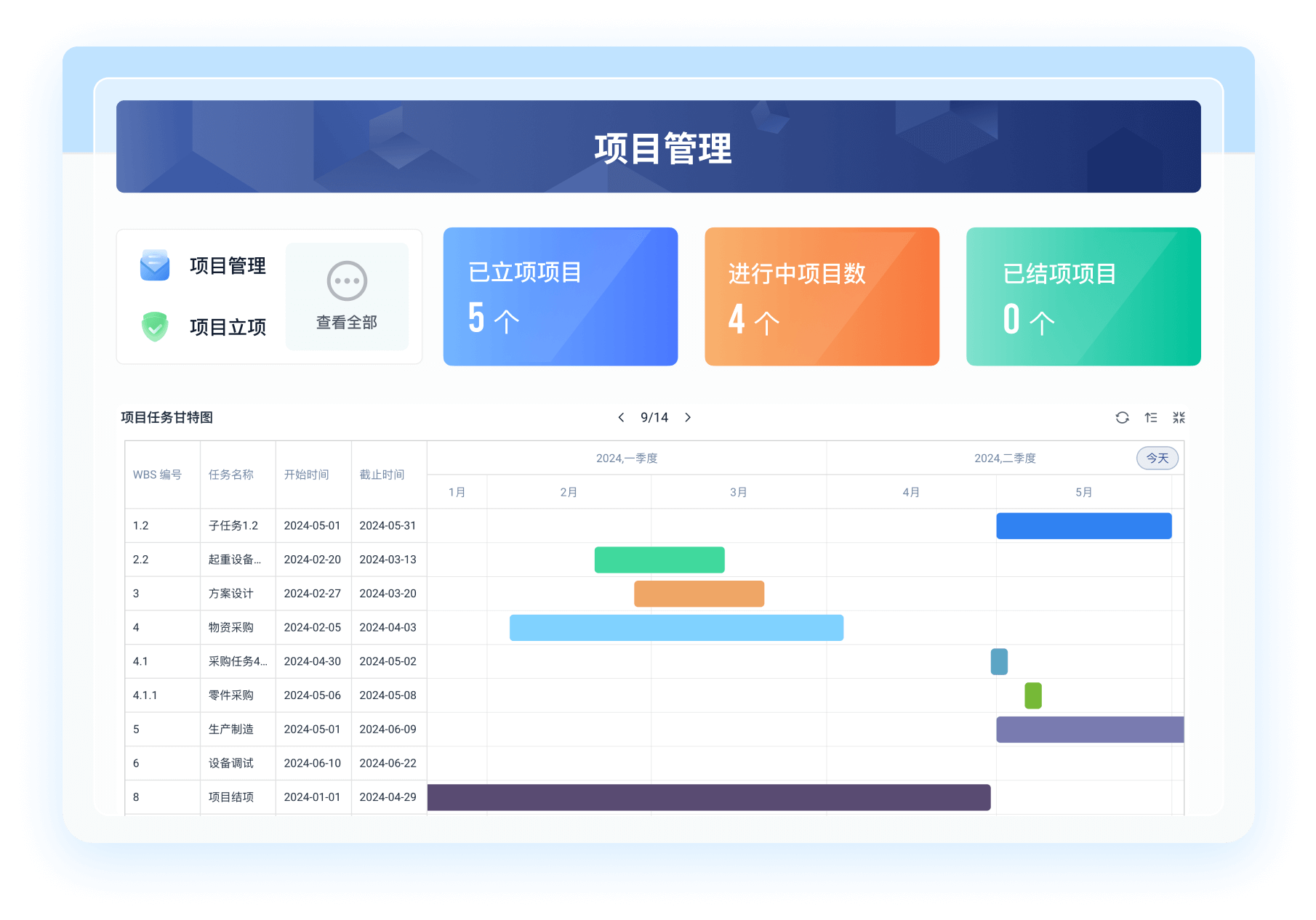

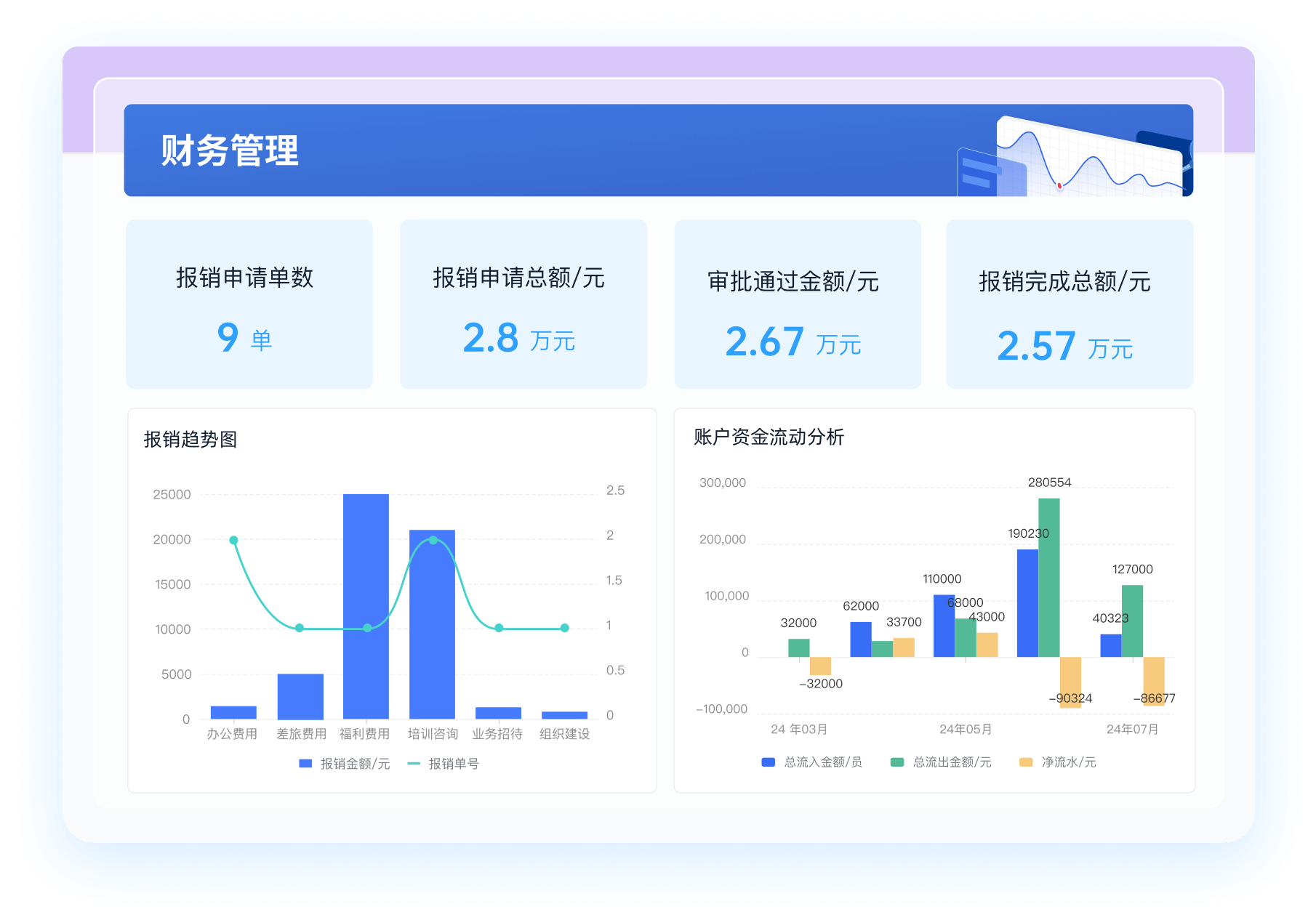

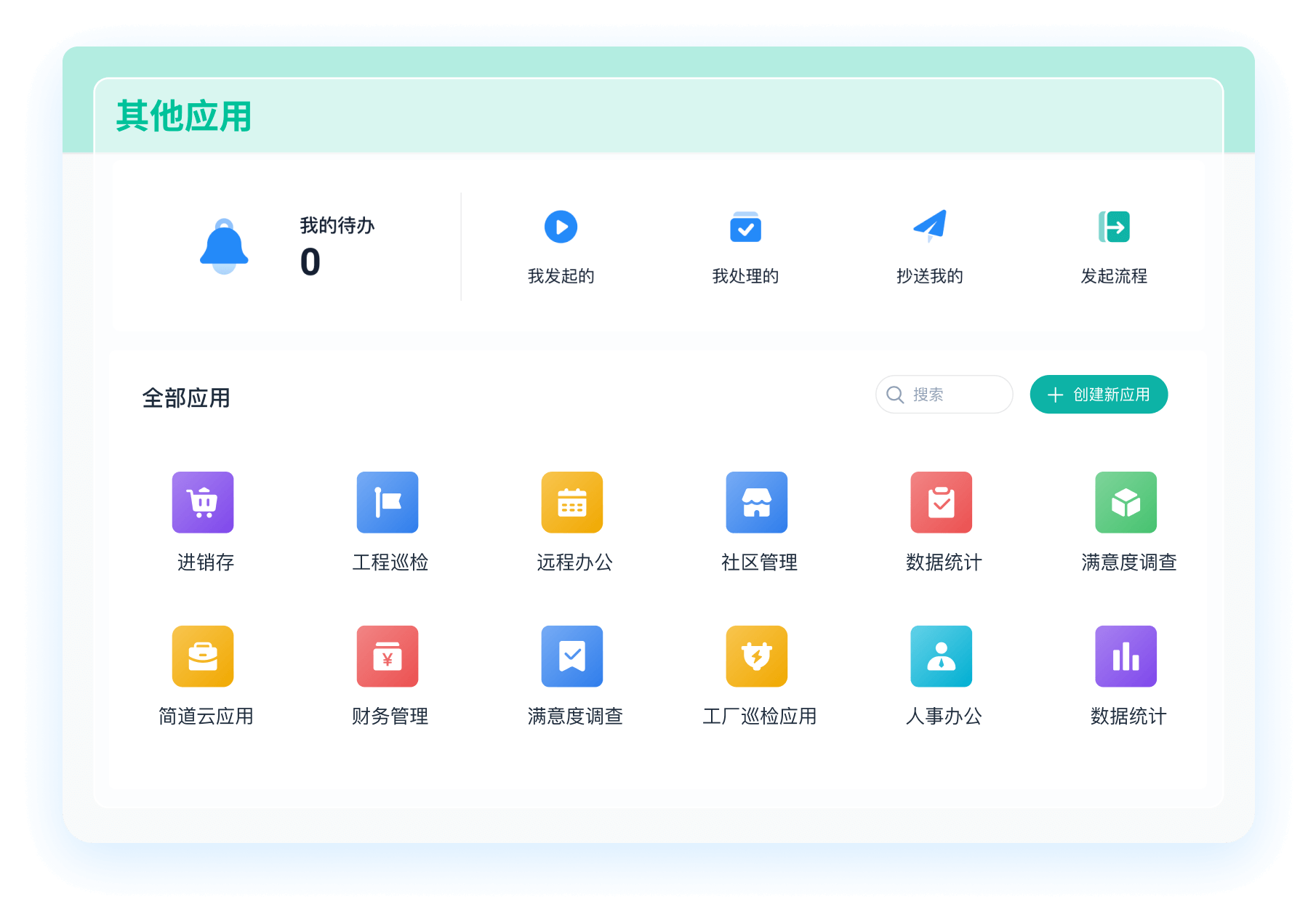

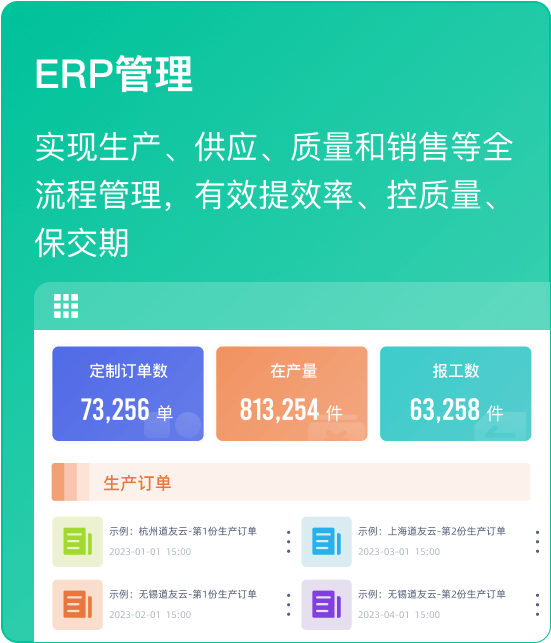

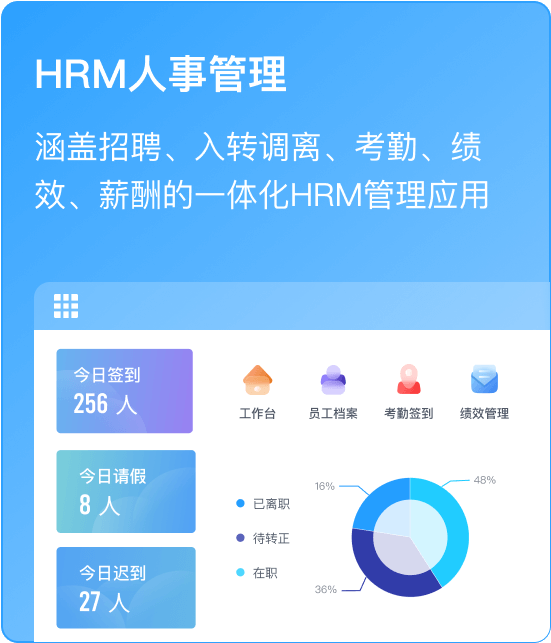

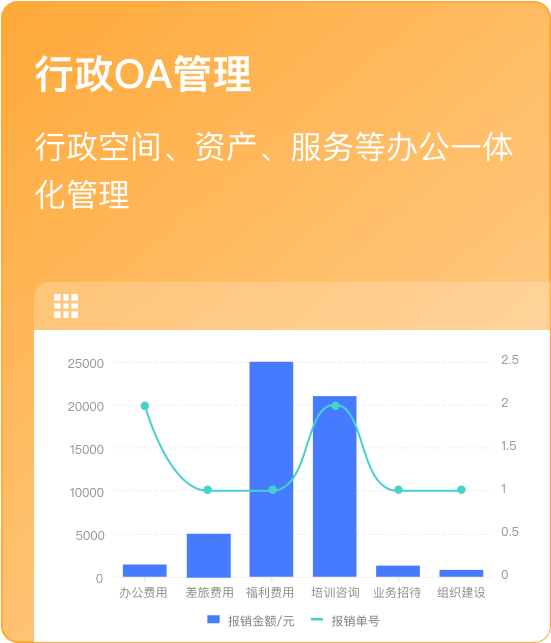

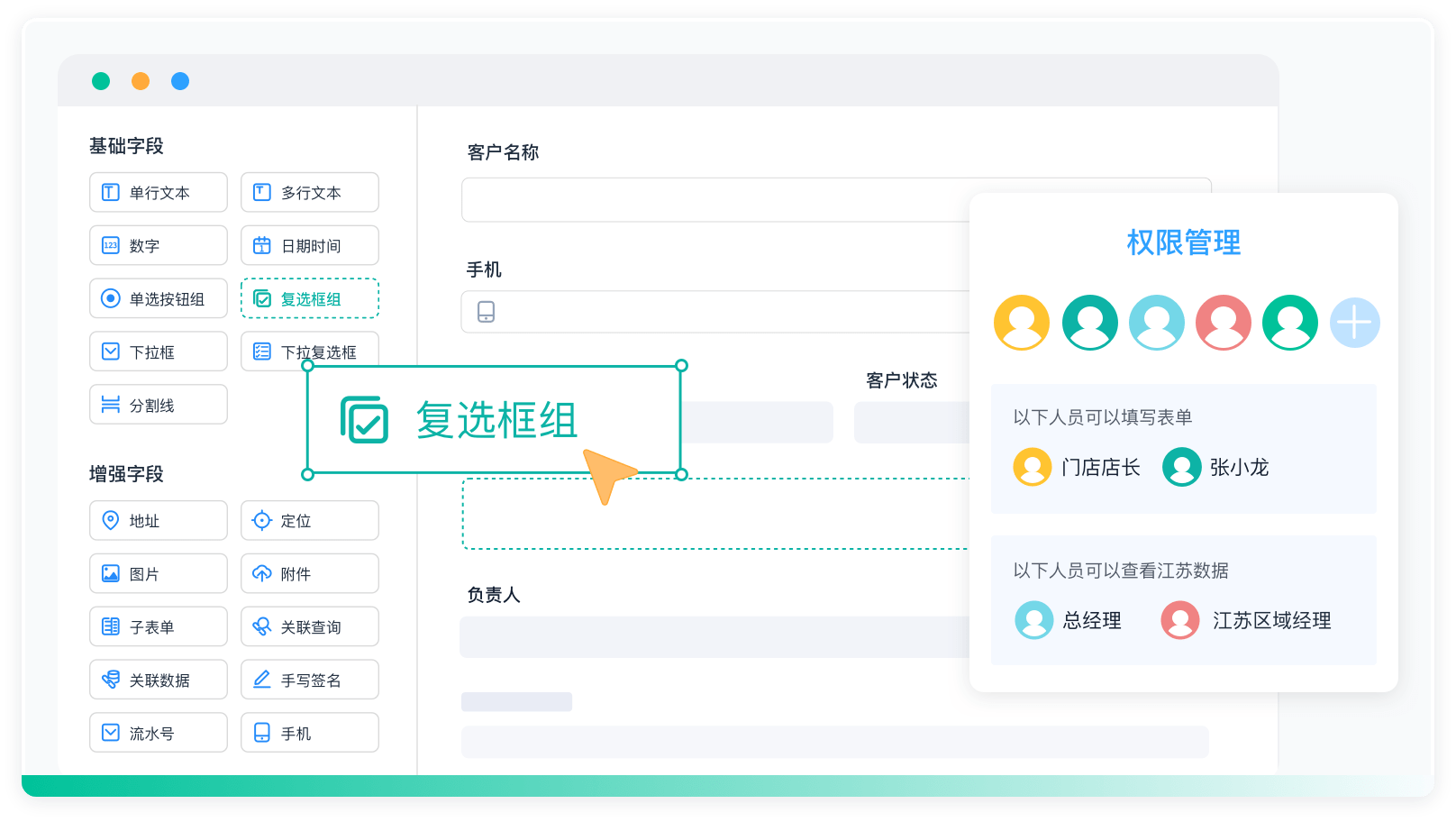

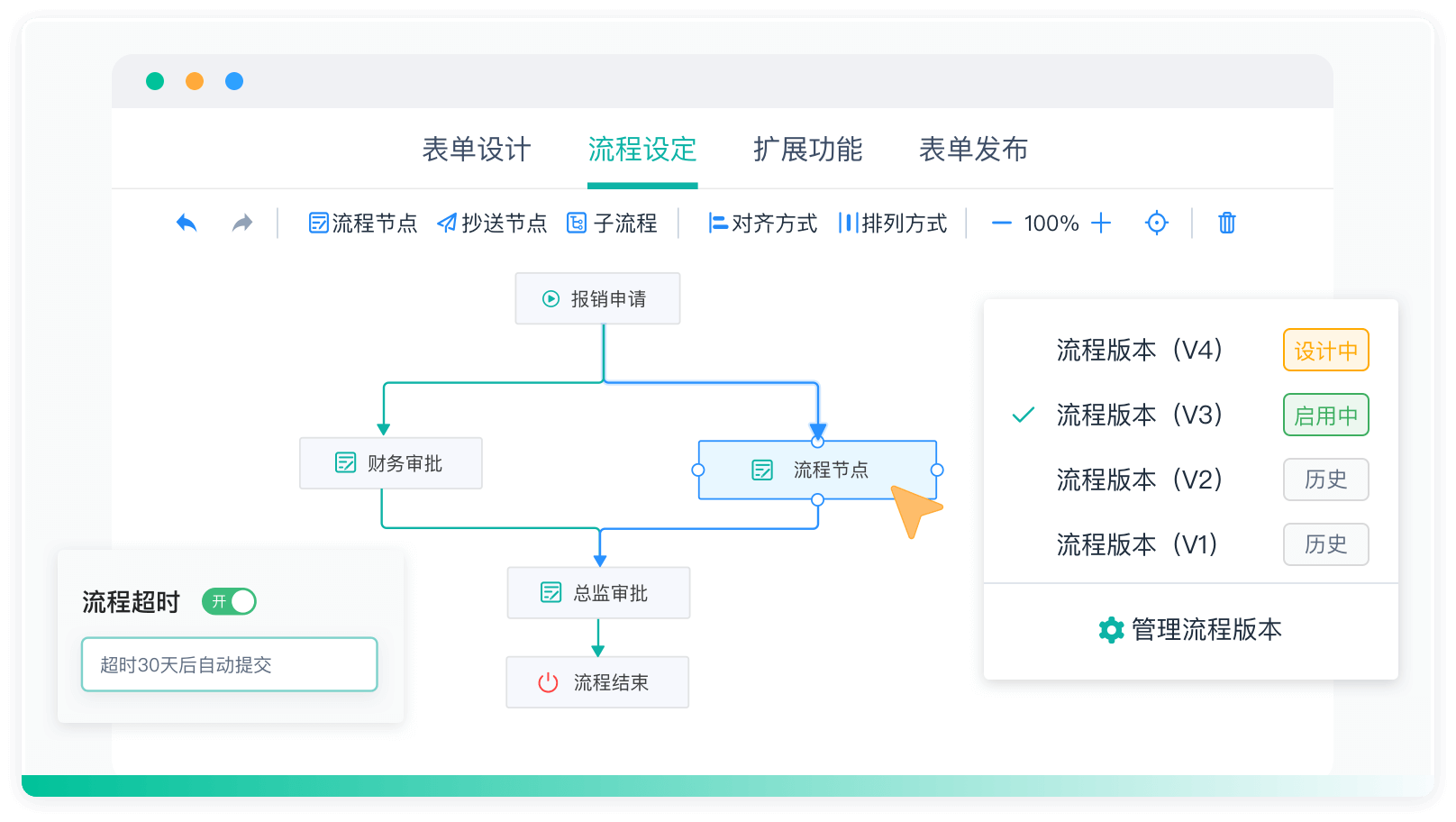

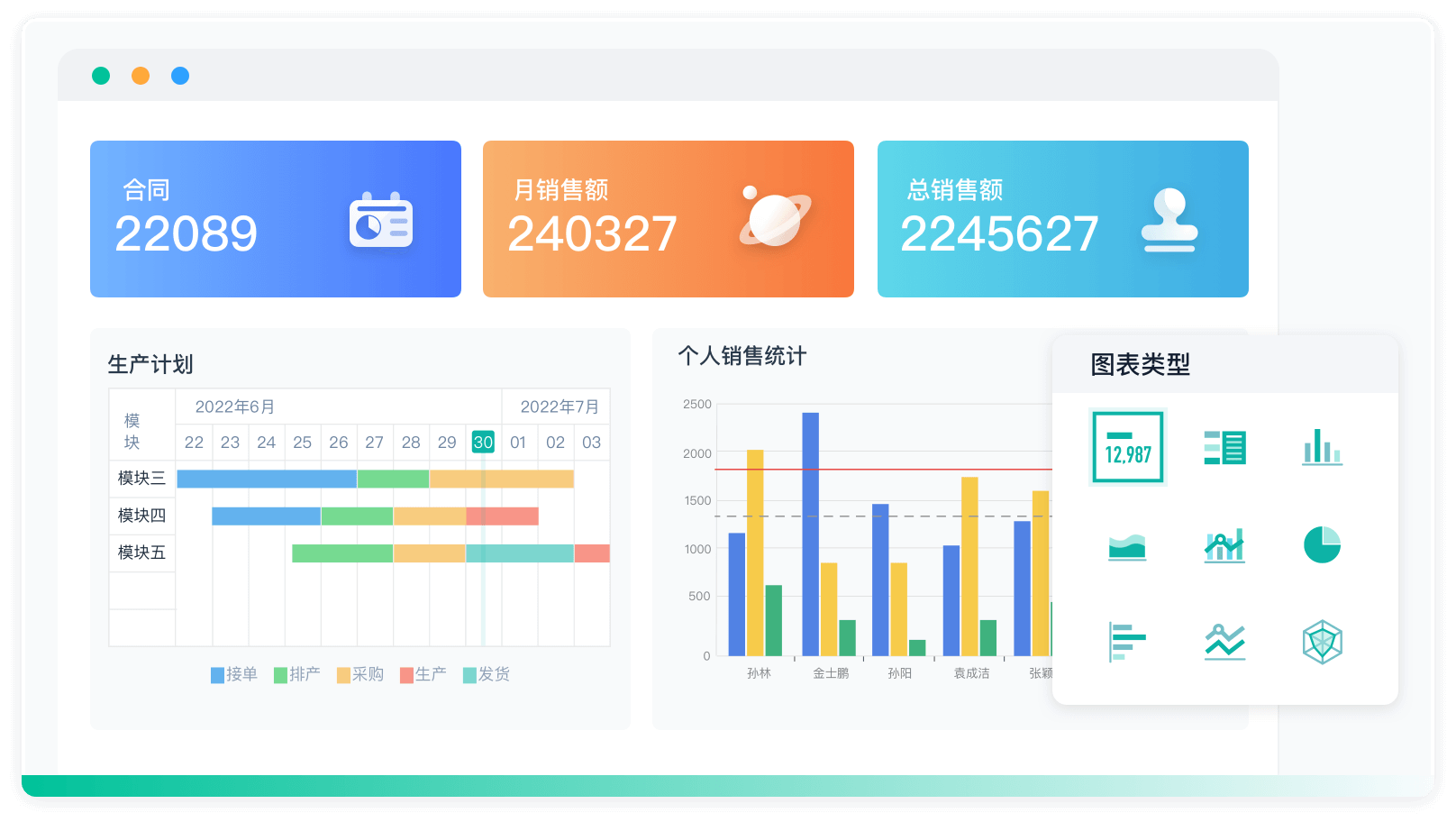

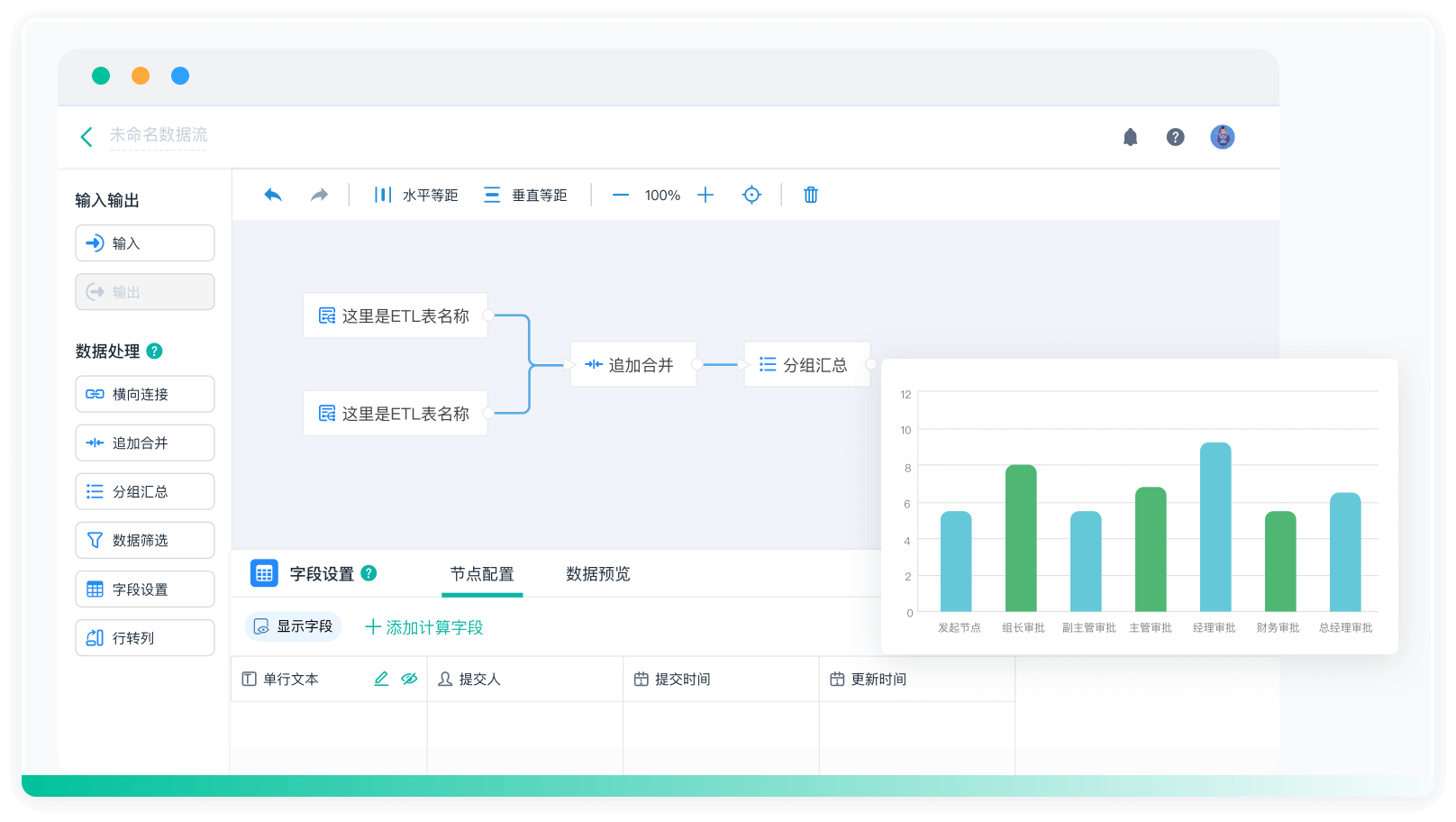

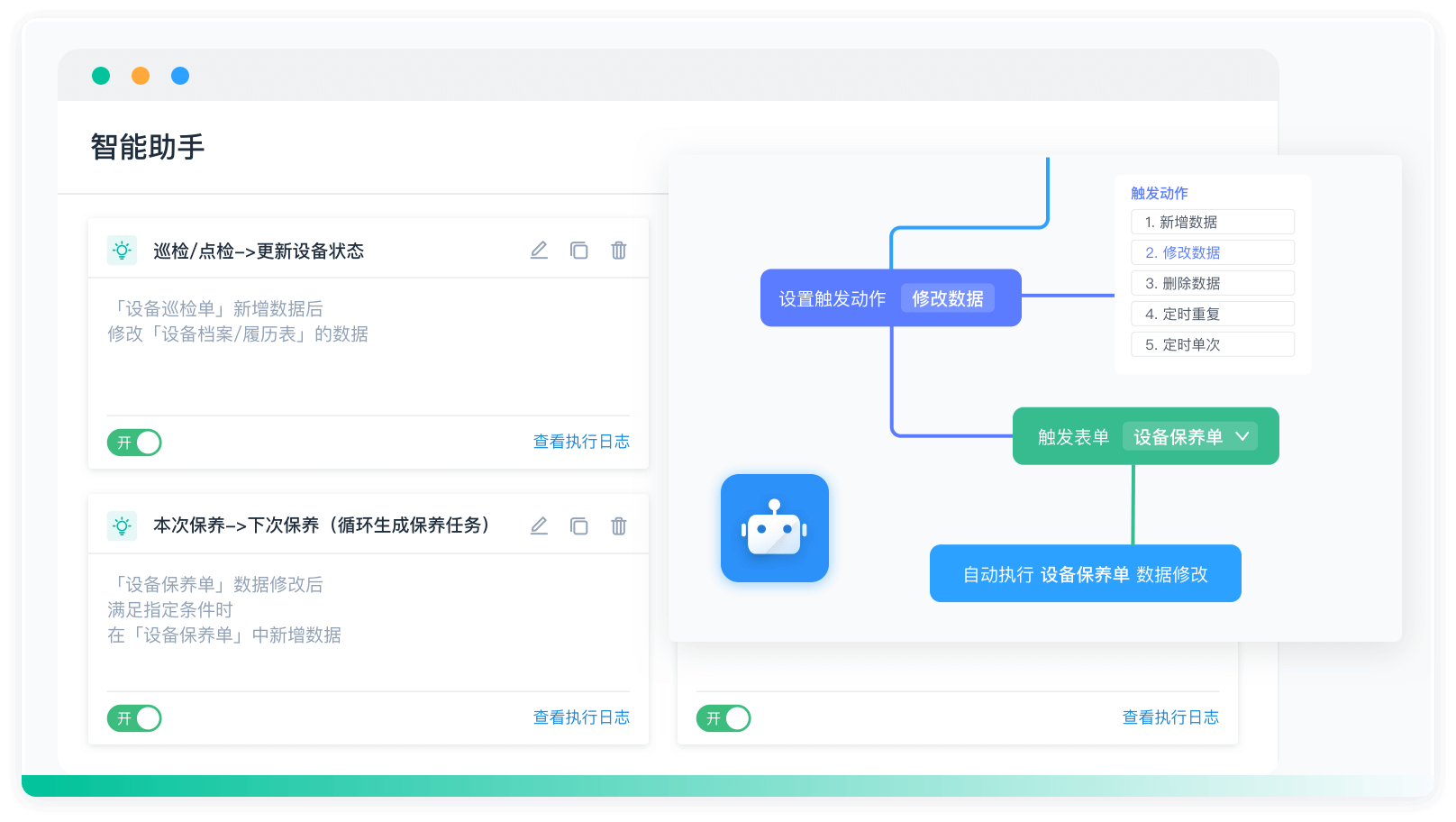

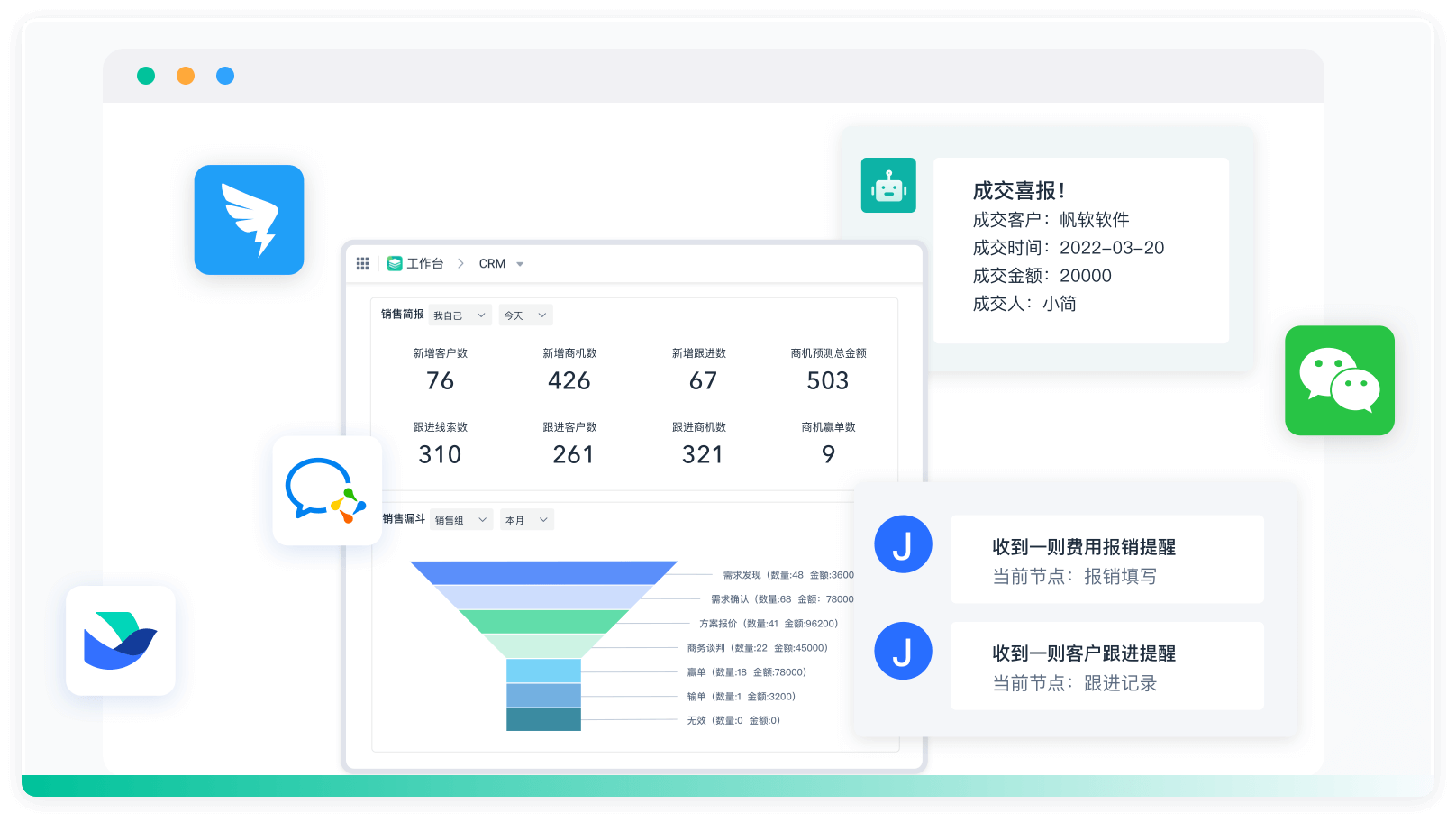

根据具体项目需求,选择合适的配置管理方式,可以提高Spark项目的可维护性和稳定性。对于企业级的业务管理系统,简道云提供了低代码和零代码开发平台,可以快速开发和管理业务系统,简化配置管理工作。更多信息请访问简道云官网:https://s.fanruan.com/kw0y5

相关问答FAQs:

如何有效管理Spark项目的配置?

在管理Spark项目的配置时,合理的策略和工具能够显著提升项目的效率和可维护性。首先,了解Spark的配置机制是关键。Spark应用的配置主要通过SparkConf对象进行管理,支持在代码中直接设置,也可以通过配置文件进行集中管理。建议使用application.conf或spark-defaults.conf等文件来统一管理配置,这样可以确保在不同环境中快速切换,并减少硬编码的风险。

此外,利用环境变量和系统属性也是一种有效的配置管理方式。通过在启动Spark应用时传递参数,能够灵活调整配置项,适应不同的运行环境。例如,可以通过--conf参数在提交作业时覆盖默认配置。

为了进一步优化配置管理,团队可以考虑使用版本控制系统来跟踪配置文件的变化,这样可以在不同版本之间轻松切换。同时,制定清晰的命名规范和注释规则,可以帮助团队成员快速理解配置的目的和用法。

Spark项目配置的常见错误及解决方案有哪些?

在管理Spark项目配置的过程中,常见的错误可能会导致性能问题或运行失败。最常见的错误之一是配置项的拼写错误或不一致性。确保在多个地方使用相同的配置项名称是至关重要的,建议使用IDE的自动补全功能来降低拼写错误的概率。

另一个常见问题是配置值不适合当前的执行环境。例如,在开发环境中可能使用较小的资源配置,而在生产环境中则需要更高的资源配置。为了解决这个问题,可以使用不同的配置文件来管理不同的环境,确保每个环境都有适合的配置。

此外,某些配置项可能会相互影响,导致难以预测的行为。例如,设置过高的并行度可能会导致资源竞争,从而影响性能。对这些配置项进行性能测试,并根据实际负载情况进行调整是非常必要的。

有哪些工具和最佳实践可以帮助管理Spark项目配置?

为了更好地管理Spark项目的配置,团队可以使用一些工具和最佳实践。首先,使用Apache Maven或Gradle等构建工具可以帮助管理项目依赖和配置,确保在构建过程中自动应用正确的配置。

在部署方面,Docker和Kubernetes等容器化技术能够为Spark项目提供一致的运行环境,通过定义容器的配置文件,可以轻松管理和复制配置。这种方式不仅提高了环境的可移植性,还减少了“在我机器上可以运行”的问题。

对于监控和调优,使用Apache Spark自带的Web UI可以实时查看应用的执行情况和资源使用情况,从而为配置优化提供数据支持。此外,集成Prometheus和Grafana等监控工具,可以实时捕获性能指标,并帮助团队发现潜在的配置问题。

最后,团队应定期进行配置审查和优化,确保配置文件随着项目的发展而不断更新,以适应新的需求和技术变化。通过持续的反馈和迭代,最终实现高效、灵活的Spark项目配置管理。

最后分享一下我们公司在用的项目管理软件的模板,可直接用,也可以自主修改功能: https://s.fanruan.com/kw0y5;

阅读时间:7 分钟

阅读时间:7 分钟  浏览量:2382次

浏览量:2382次

《零代码开发知识图谱》

《零代码开发知识图谱》

《零代码

新动能》案例集

《零代码

新动能》案例集

《企业零代码系统搭建指南》

《企业零代码系统搭建指南》