要爬取CRM系统数据,可以通过API接口、数据库直接访问、网页抓取、数据导出这几种方法。API接口是最推荐的方式,因为它通常提供了更稳定和结构化的数据访问途径。API接口通常由CRM系统官方提供,文档详尽,接口稳定,安全性高。通过API接口获取数据,不仅可以保证数据的完整性和一致性,还能减少对CRM系统的负载影响。下面,我们将详细介绍这几种方法。

一、API接口

API接口是最常见也是最安全的方法之一。CRM系统通常提供RESTful API接口,允许用户通过HTTP请求获取数据。首先,需要获取API的访问令牌或密钥,这通常需要登录到CRM系统的开发者平台进行注册和申请。然后,通过发送HTTP请求,指定所需的数据类型和参数,从而获取JSON或XML格式的数据。这种方法的优点是安全、稳定且易于维护。可以使用各种编程语言和库,如Python的requests库,来实现数据的获取。

二、数据库直接访问

如果你有数据库的访问权限,可以直接从数据库中提取数据。这种方法需要熟悉数据库的结构和SQL查询。首先,连接到CRM系统的数据库服务器,通常需要提供数据库的地址、用户名和密码。然后,编写SQL查询语句,提取所需的数据。这种方法的优点是速度快,但缺点是需要较高的技术门槛,且数据库结构可能复杂,不易理解。

三、网页抓取

网页抓取是一种较为通用的方法,但也是最不推荐的方法之一。通过编写爬虫程序,模拟用户操作,抓取网页上的数据。这种方法适用于没有API接口且无法直接访问数据库的情况。可以使用Python的BeautifulSoup和Selenium库来实现网页抓取。首先,使用Selenium模拟登录操作,然后通过BeautifulSoup解析网页,提取所需的数据。虽然这种方法通用性强,但存在很多问题,如网页结构变动、反爬虫机制等。

四、数据导出

许多CRM系统提供数据导出的功能,允许用户将数据导出为CSV、Excel等格式。用户可以通过CRM系统的用户界面手动导出数据,然后编写脚本对导出的数据进行处理和分析。这种方法适用于数据量较小且不需要实时更新的情况。优点是操作简单,无需编写复杂的代码,缺点是无法实现自动化和实时性。

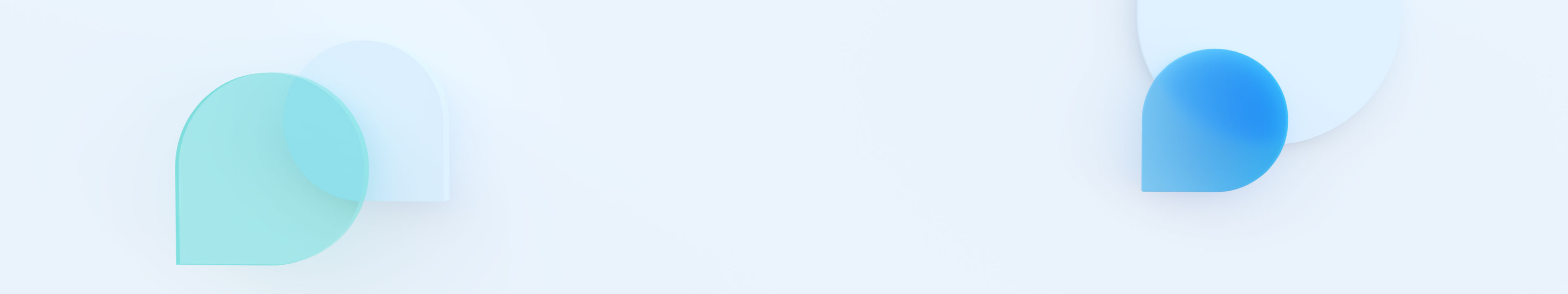

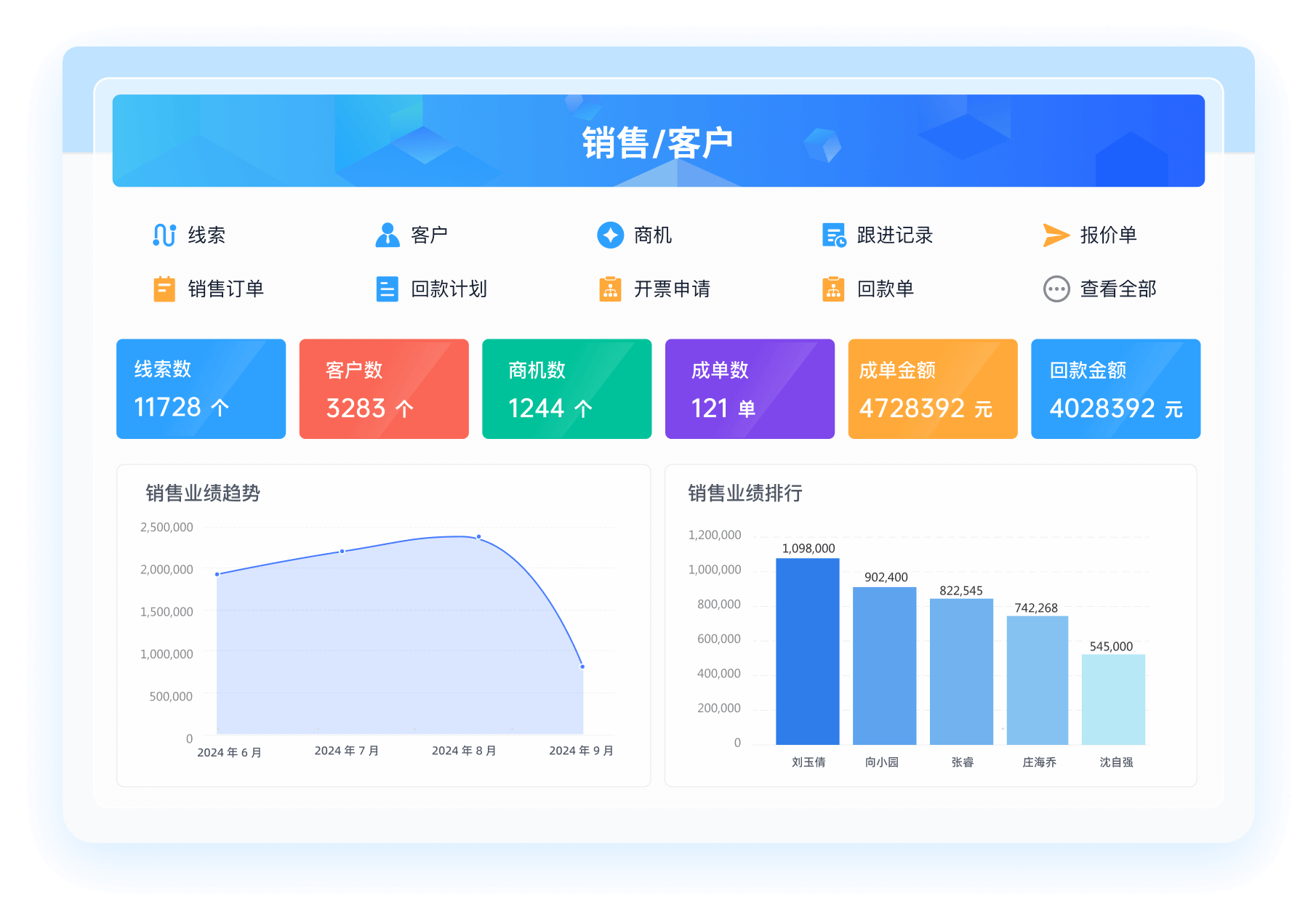

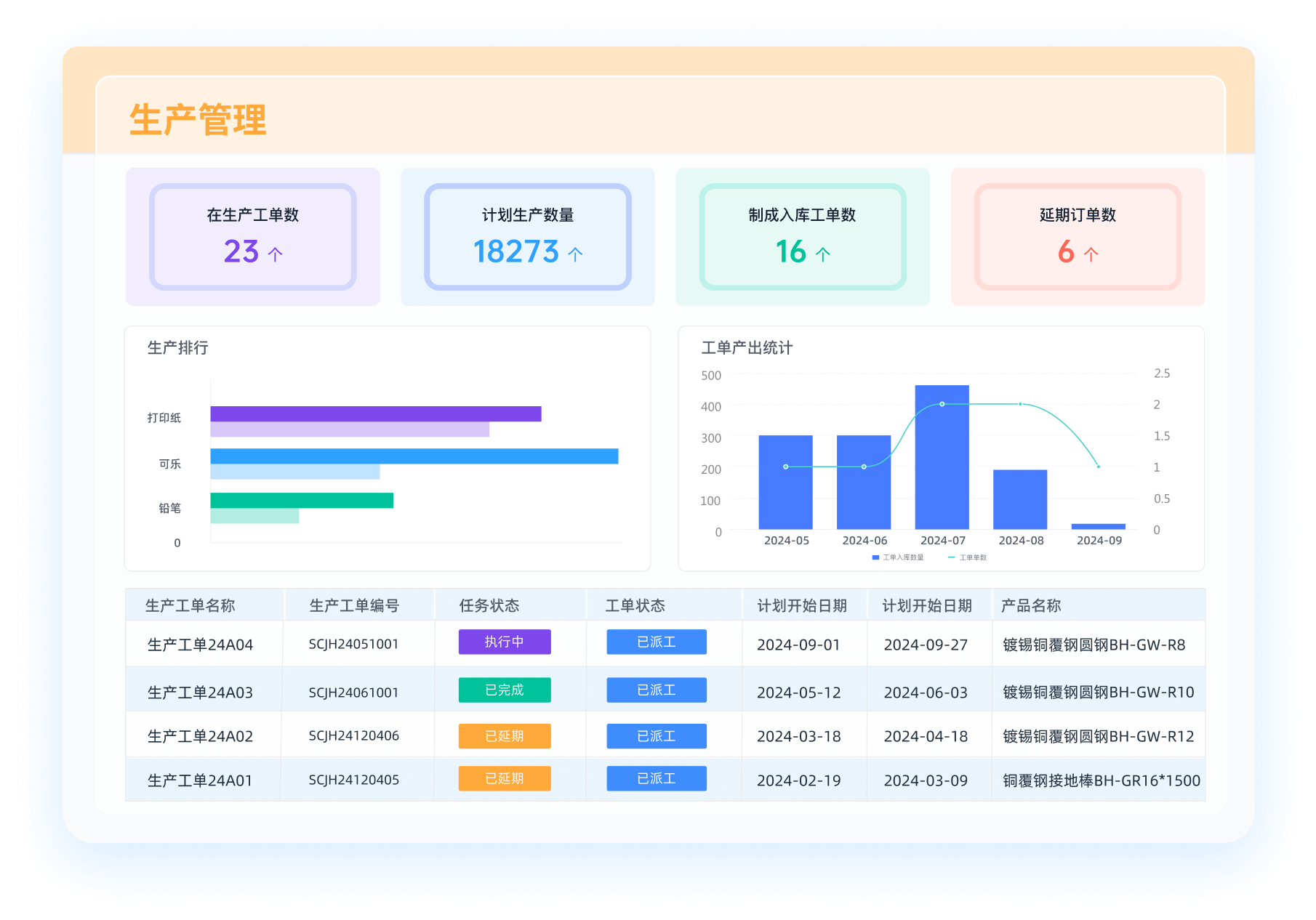

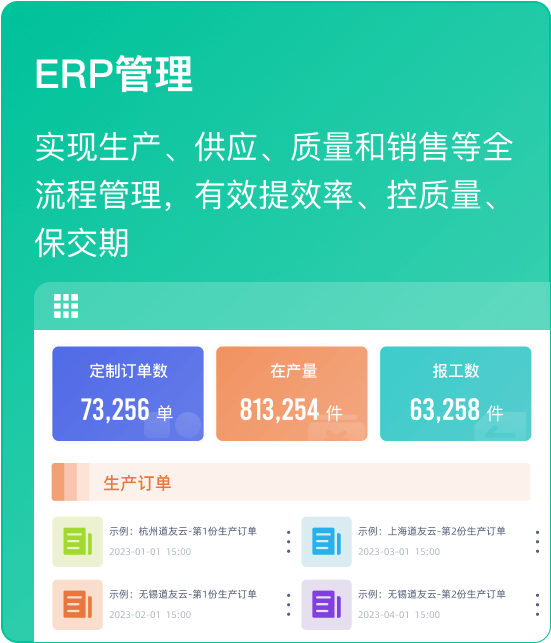

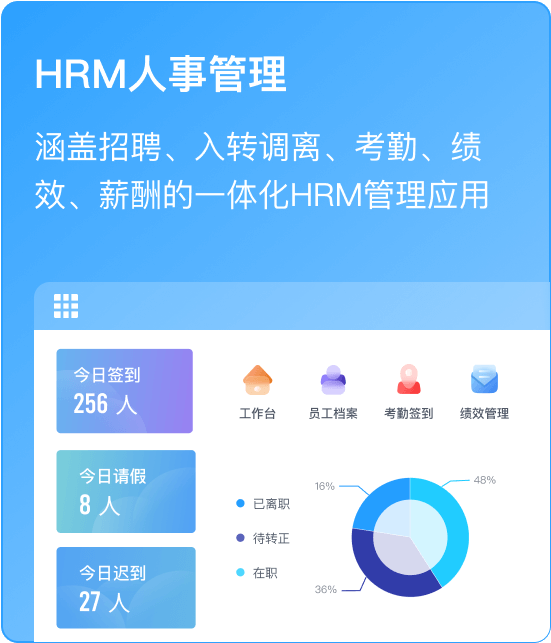

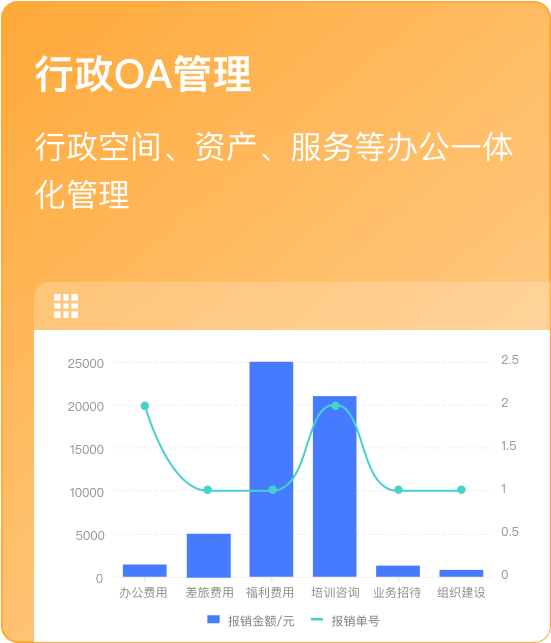

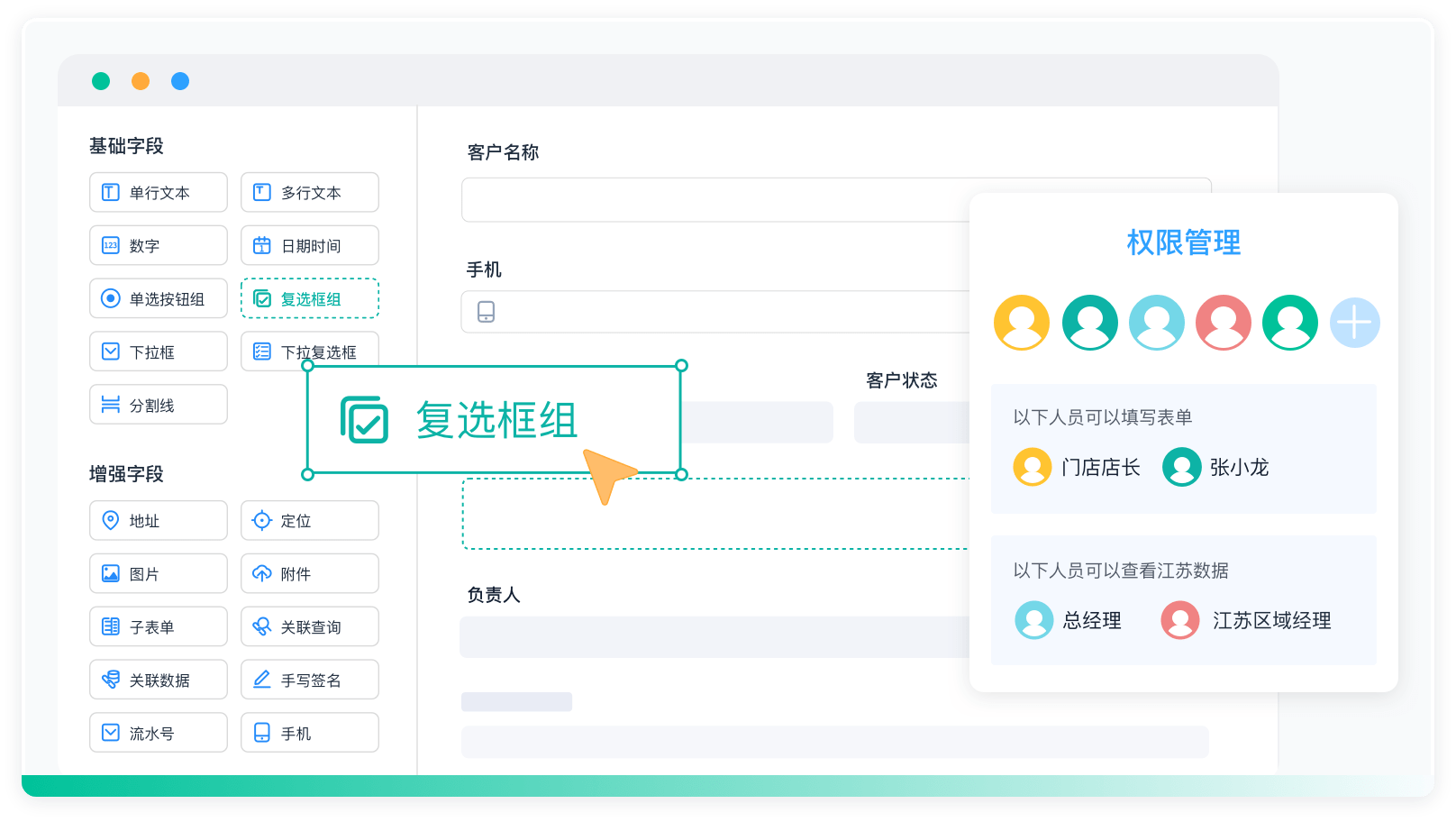

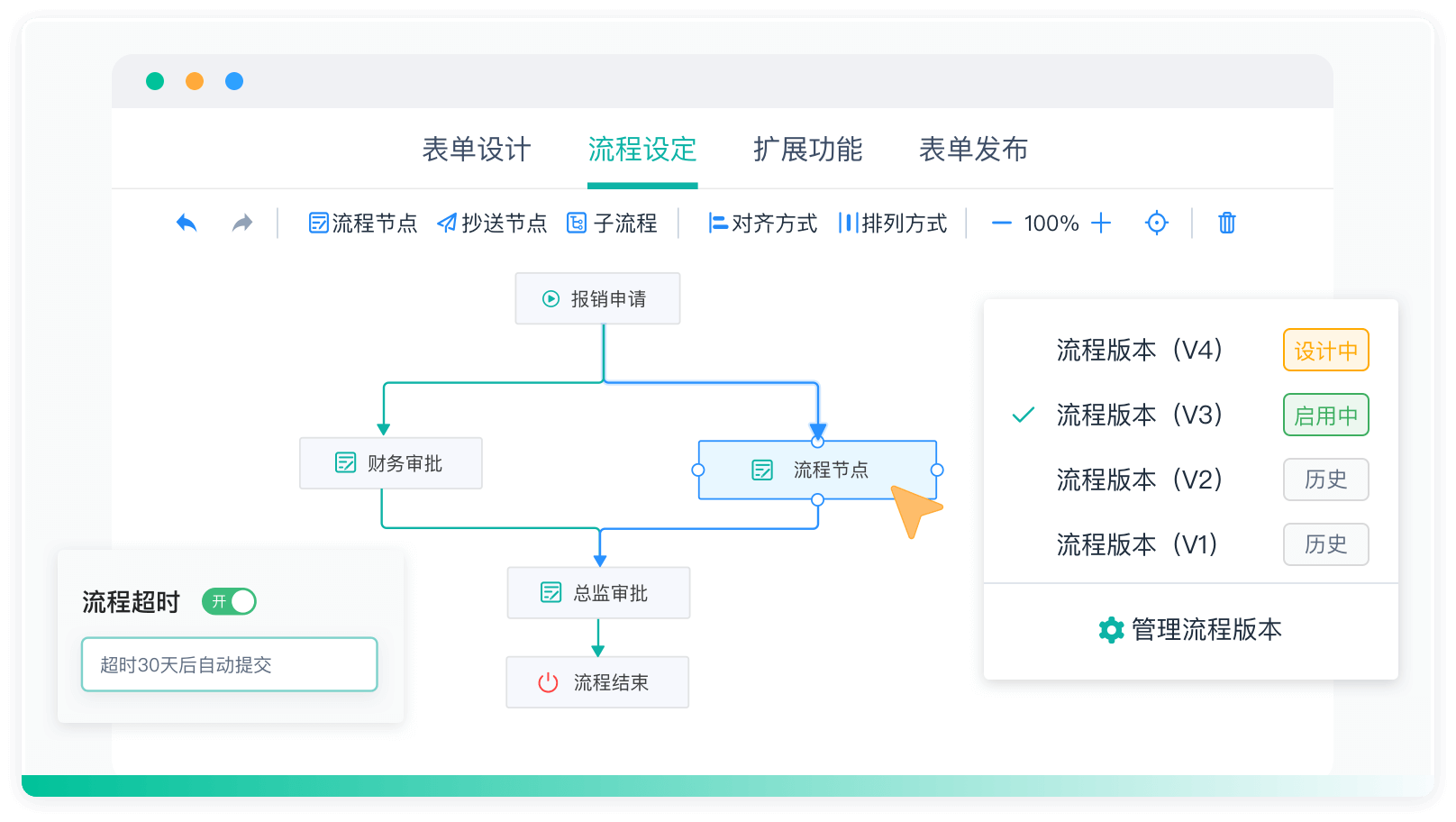

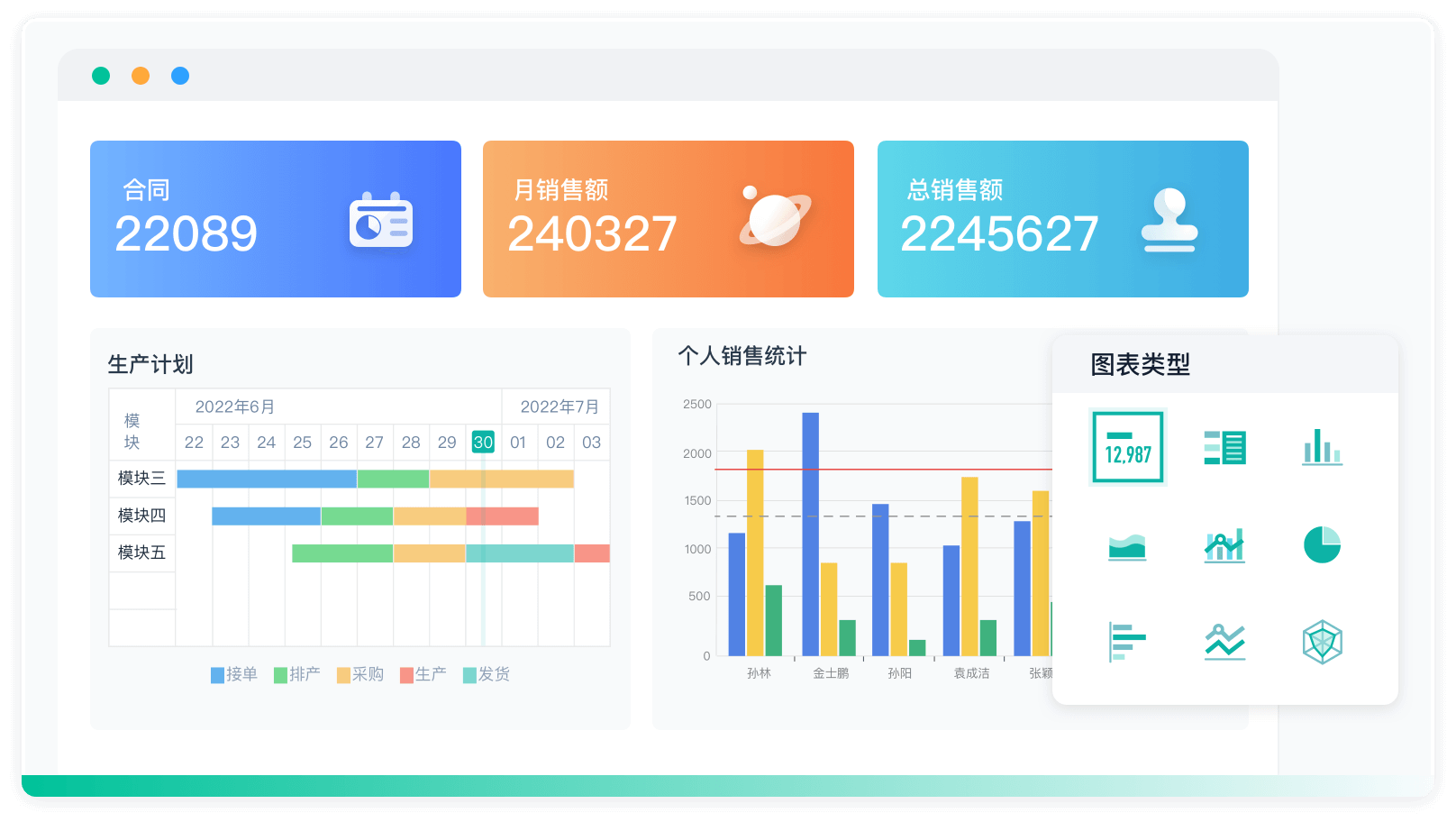

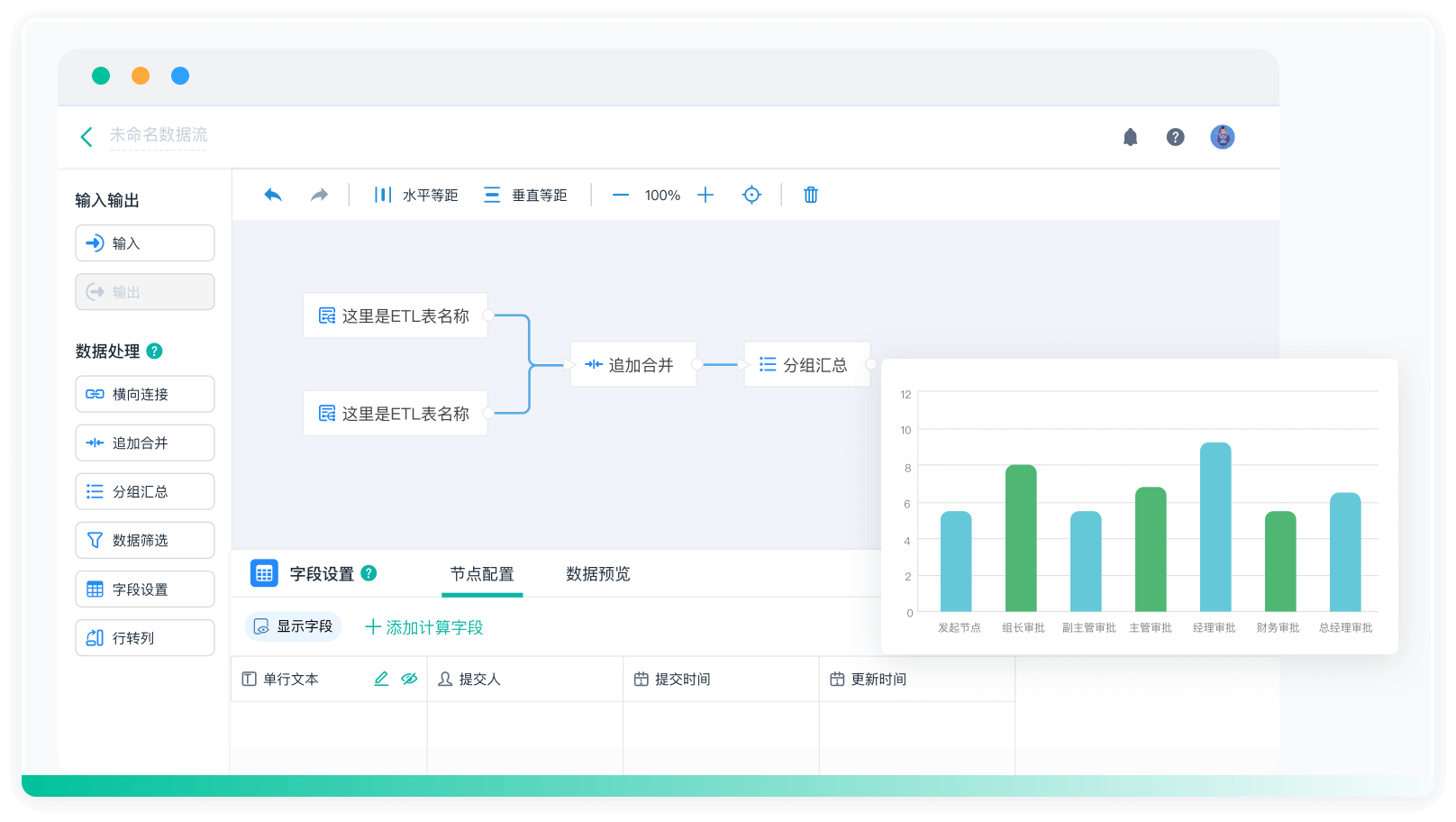

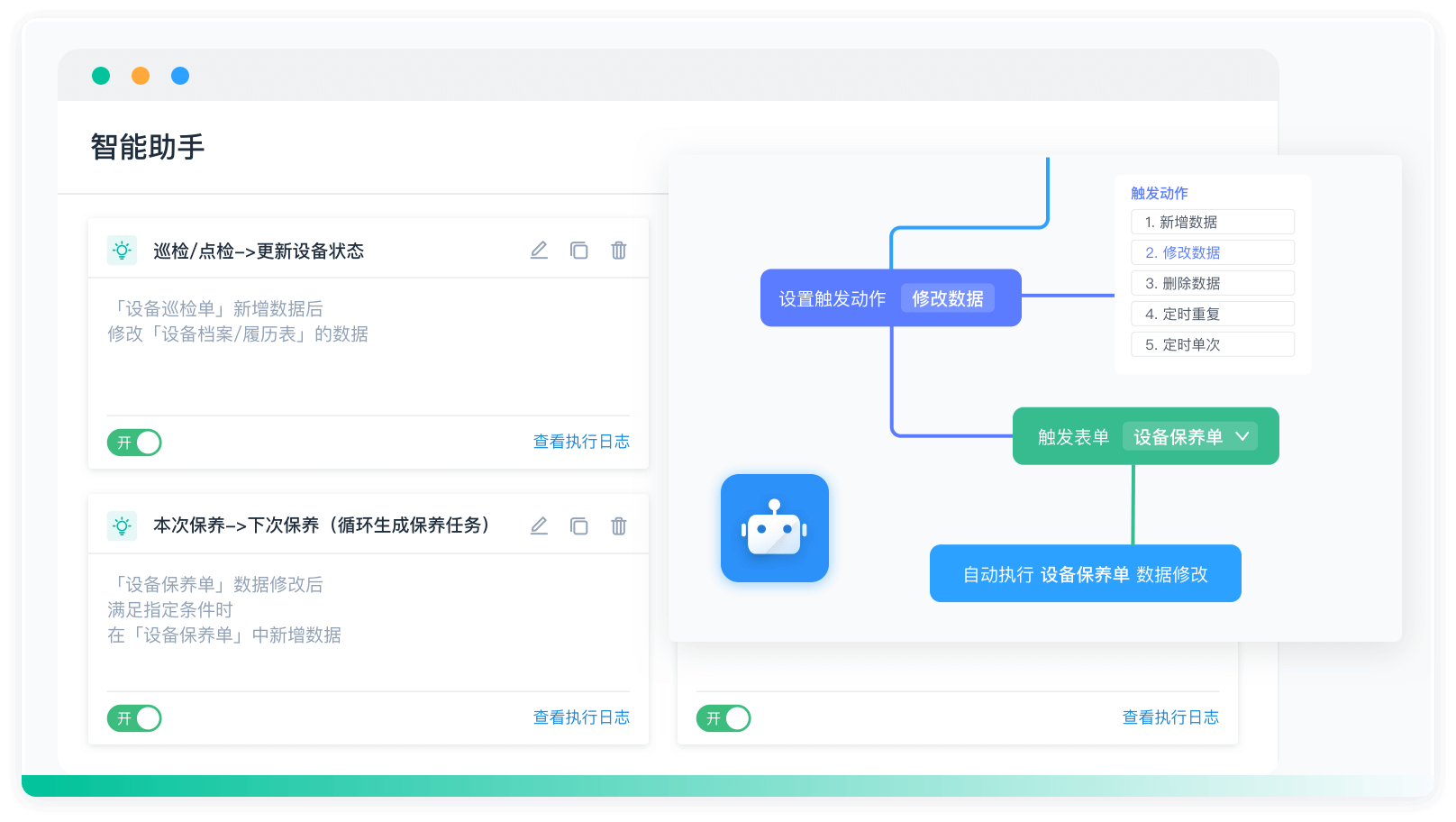

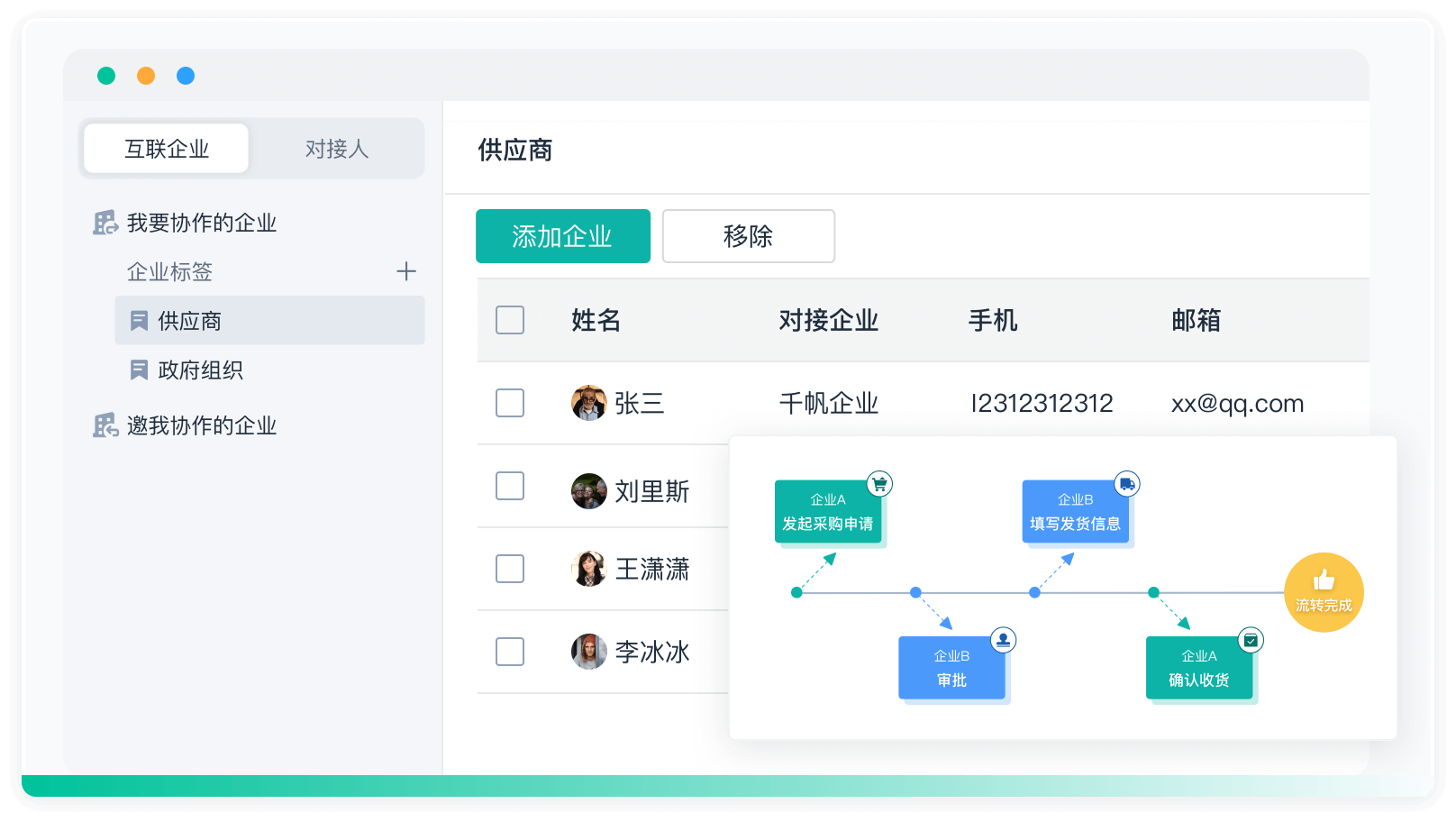

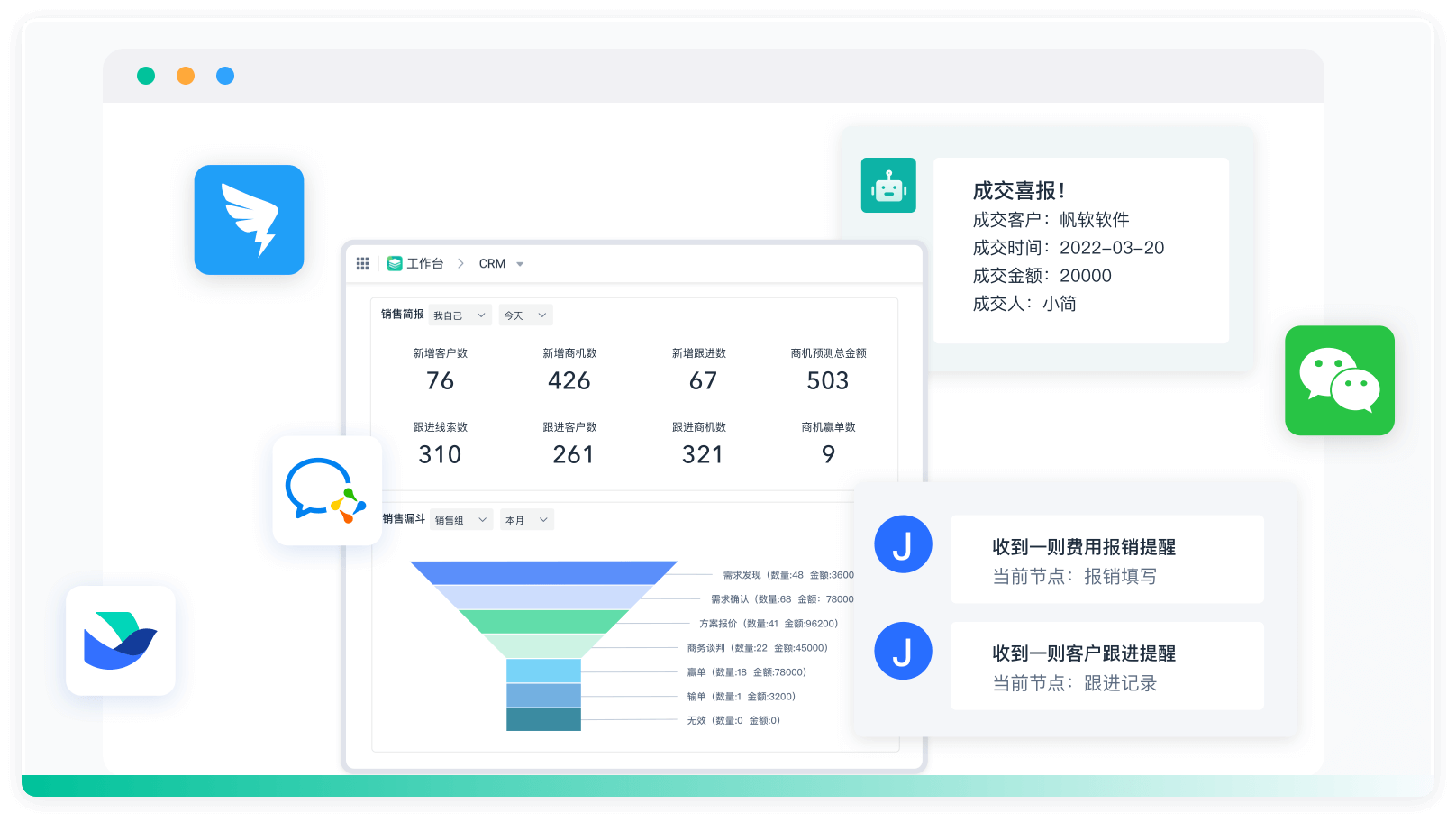

五、使用第三方工具

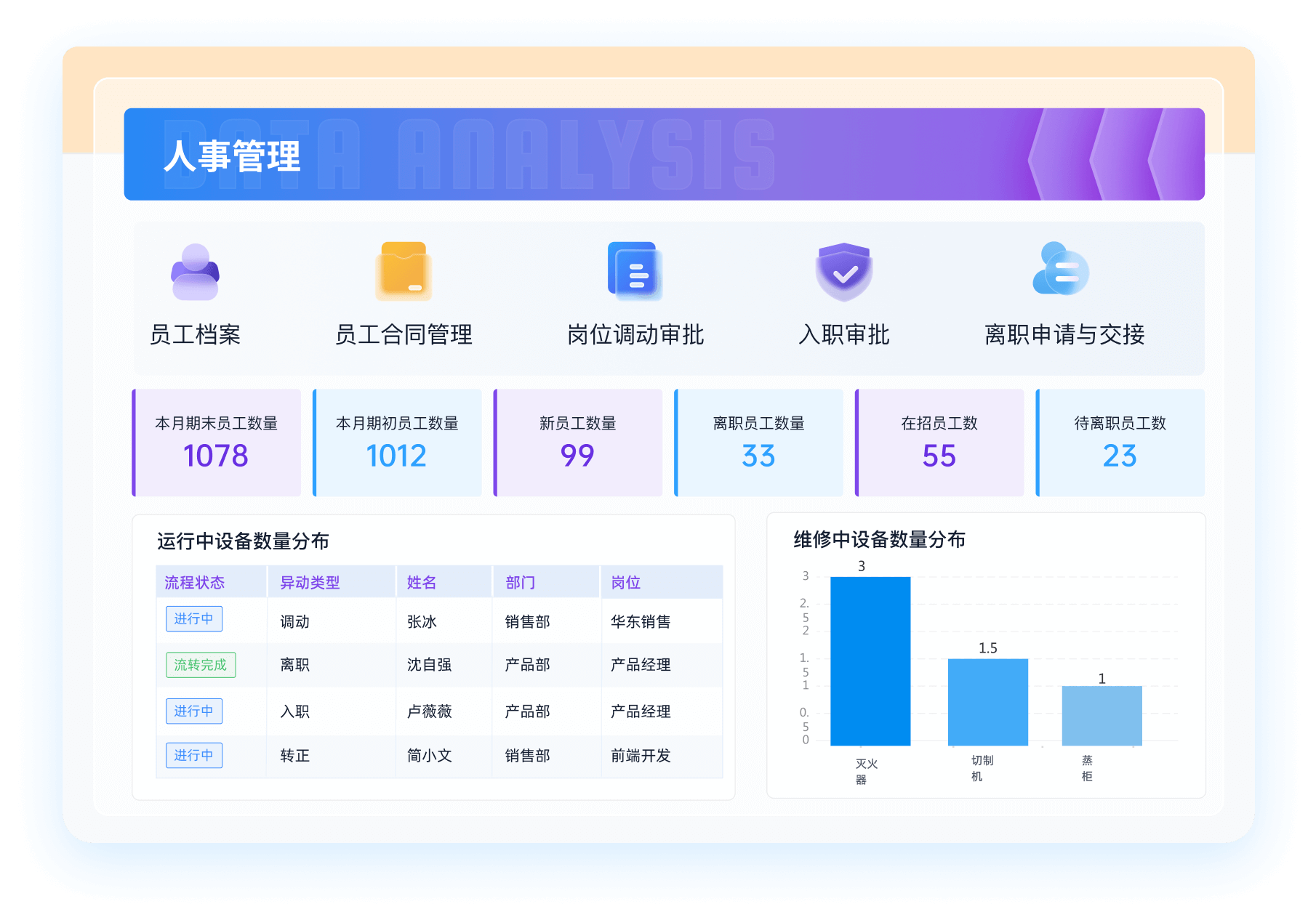

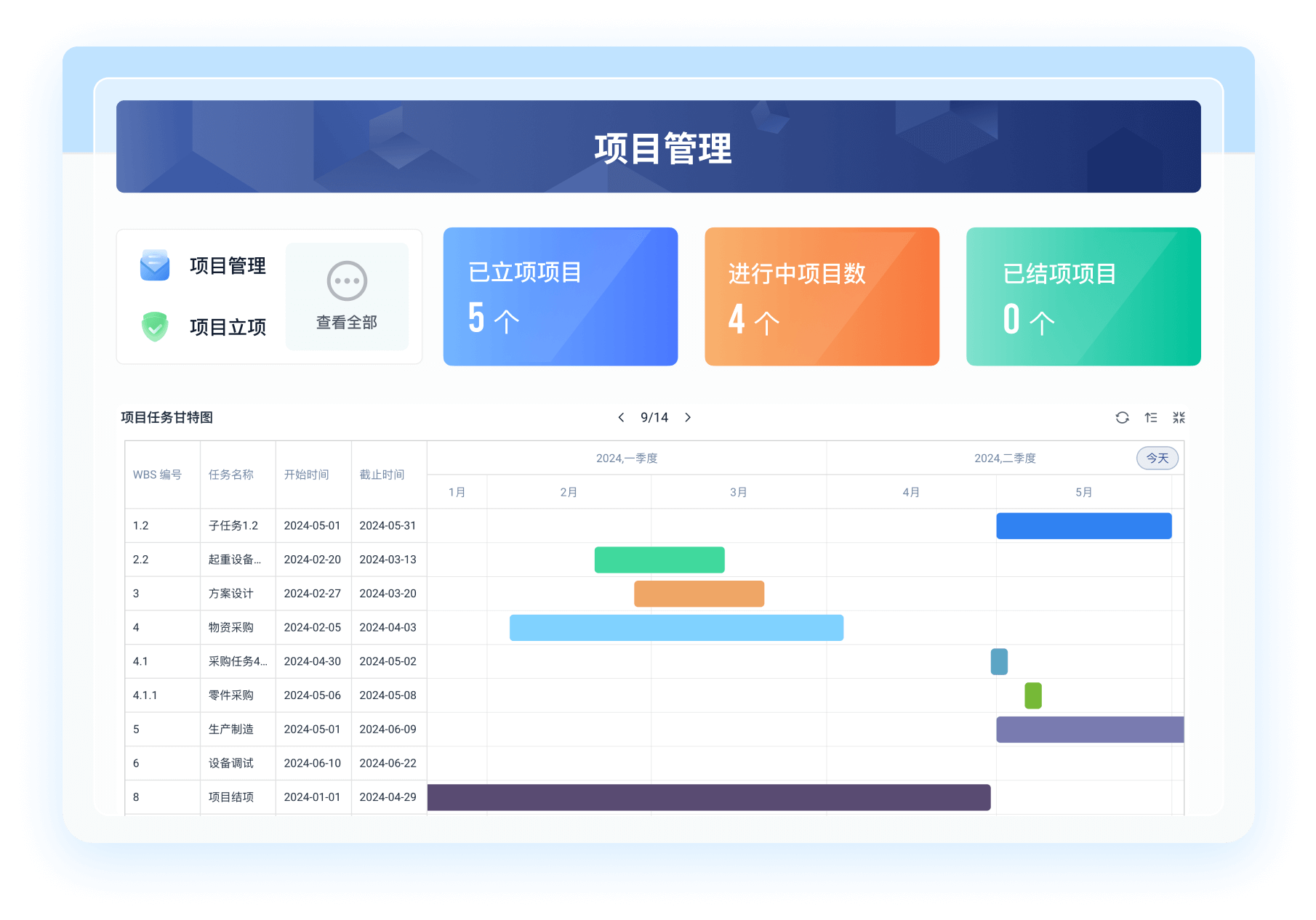

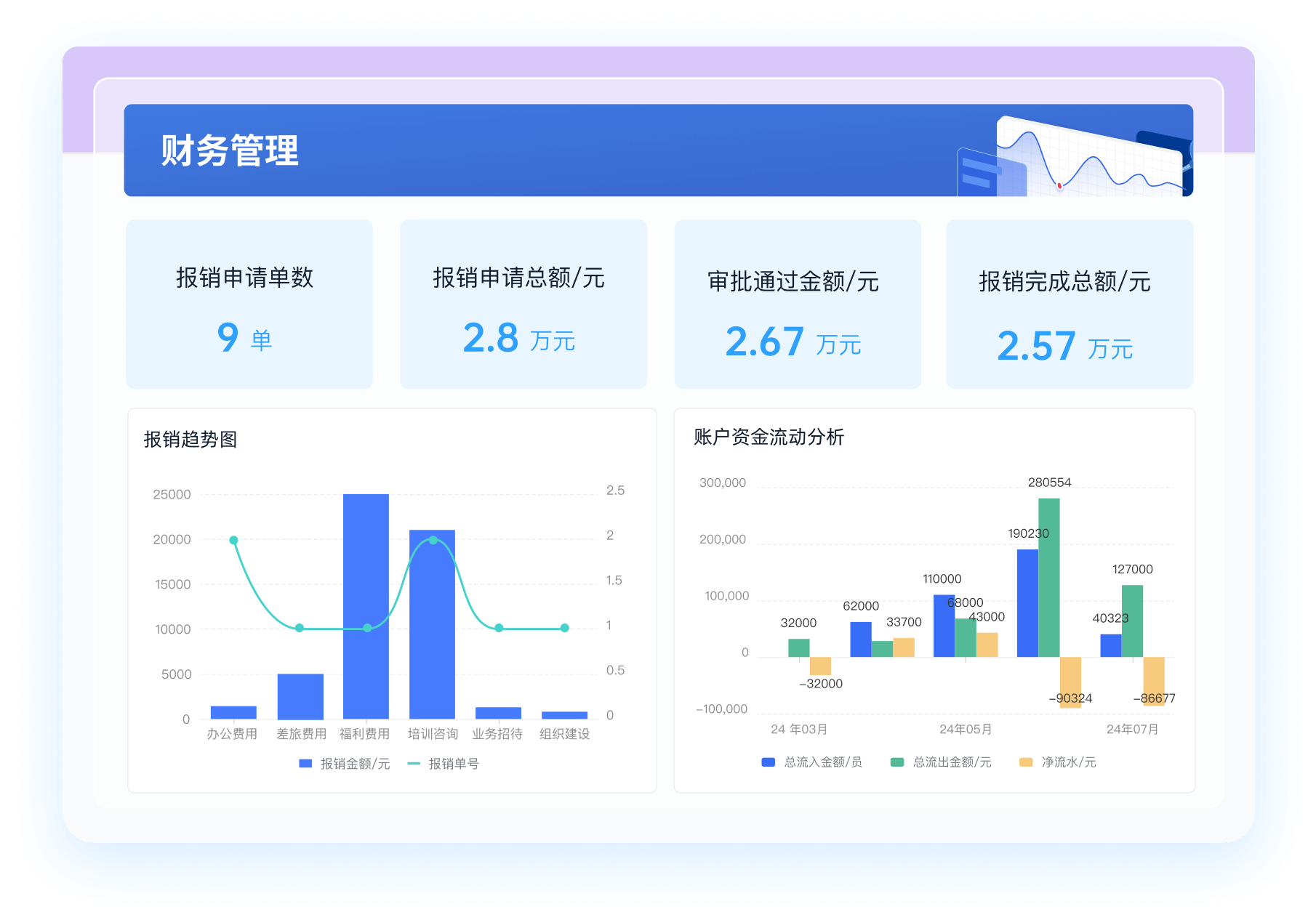

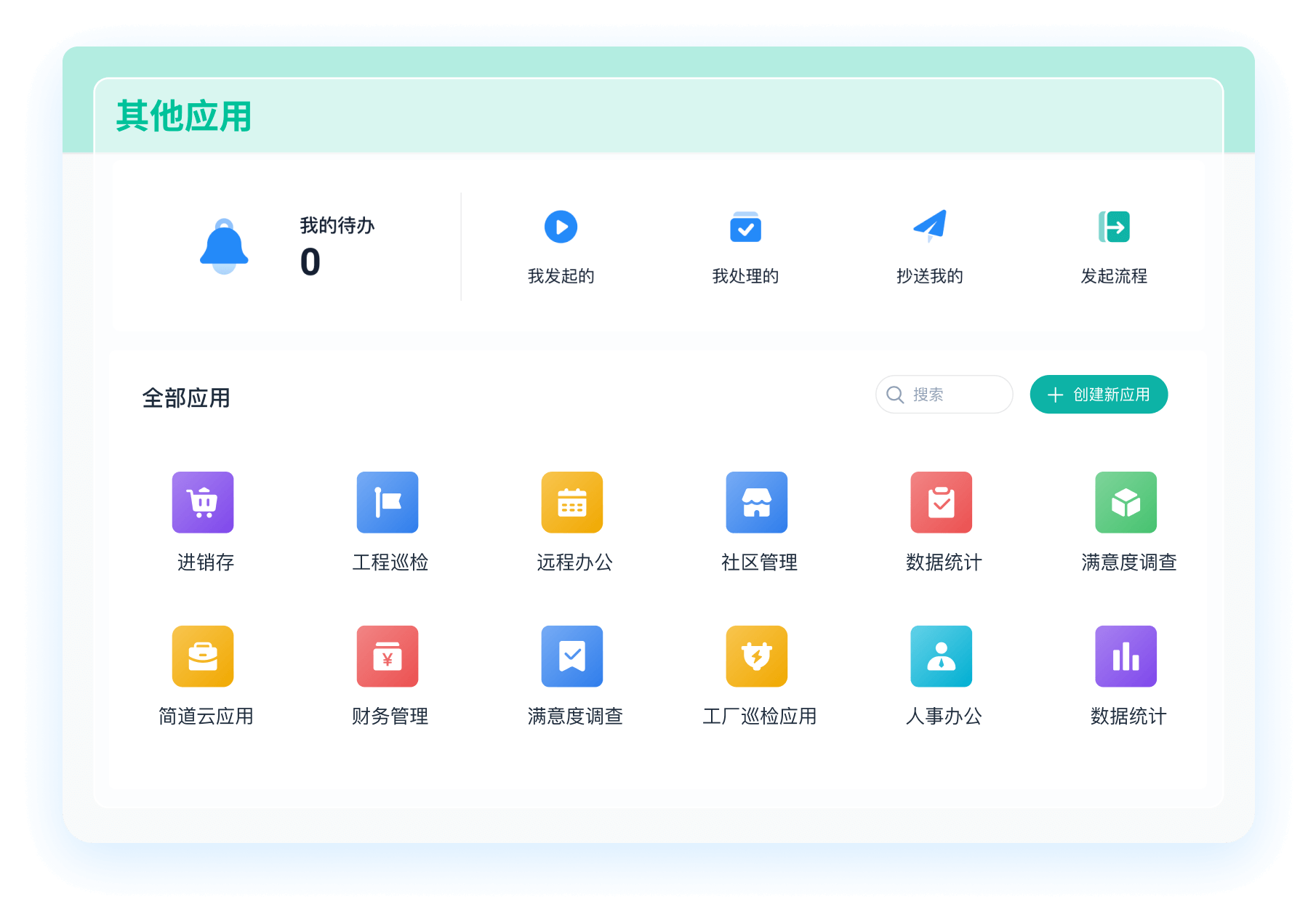

有许多第三方工具和平台,如简道云,可以帮助你更方便地获取和处理CRM系统数据。简道云官网: https://s.fanruan.com/6mtst;。这些工具通常提供图形化界面,用户无需编写代码即可完成数据的获取和处理。通过第三方工具,可以将不同来源的数据整合到一个平台上,进行统一分析和管理。优点是使用简单,适合非技术用户,缺点是可能需要付费,且功能受限于工具本身。

六、数据安全和合规性

在获取CRM系统数据的过程中,必须注意数据的安全性和合规性。首先,确保所使用的方法不会对CRM系统的正常运行造成影响,尤其是在进行大规模数据抓取时。其次,遵守数据保护法律法规,如GDPR、CCPA等,确保获取和使用的数据不会侵犯用户隐私。使用API接口时,务必妥善保管API密钥,防止泄露和滥用。

七、数据处理和分析

获取数据后,通常还需要对数据进行处理和分析。可以使用Python的pandas库进行数据清洗、转换和分析。首先,将获取的数据加载到pandas DataFrame中,然后进行各种操作,如缺失值处理、数据类型转换、数据聚合等。经过处理后的数据可以用于进一步的分析和可视化,如生成报表、绘制图表等。

八、自动化和调度

为了实现数据获取和处理的自动化,可以使用调度工具,如cron、Airflow等。通过编写调度脚本,定期运行数据获取和处理的任务,确保数据的实时性和一致性。调度工具通常提供日志记录和错误处理功能,方便用户监控任务的运行状态和排查问题。

九、案例实践

为了更好地理解上述方法,下面我们提供一个简单的案例。假设我们需要从某CRM系统获取客户数据,并进行分析。首先,通过API接口获取客户数据,使用Python的requests库发送HTTP请求,获取JSON格式的数据。然后,将数据加载到pandas DataFrame中,进行数据清洗和处理。接着,使用pandas进行数据分析,如计算客户数量、客户分布等。最后,将分析结果导出为Excel文件,并通过调度工具定期运行上述任务,实现自动化。

十、常见问题和解决方案

在实际操作过程中,可能会遇到各种问题,如API请求失败、数据库连接超时、网页抓取被封禁等。为了解决这些问题,可以采取以下措施:首先,仔细阅读API文档,确保请求参数正确,且访问频率不超过限制。其次,优化数据库查询语句,减少查询时间和资源占用。对于网页抓取,可以设置适当的延时,模拟人类操作,避免被反爬虫机制检测到。此外,及时更新爬虫代码,适应网页结构的变动。

通过本文的介绍,相信你已经对如何爬取CRM系统数据有了全面的了解。根据具体情况选择合适的方法,既能提高数据获取的效率,又能保证数据的安全和合规性。

相关问答FAQs:

如何有效地爬取CRM系统数据?

爬取CRM系统数据的过程涉及多个步骤和技术。首先,理解CRM系统的数据结构非常重要。这些系统通常有复杂的数据库和API接口,可以通过这些接口来提取所需的信息。进行数据爬取时,用户需要关注数据的合法性和隐私问题,确保遵守相关法律法规。

在技术层面,选择合适的工具和库非常关键。常用的爬虫框架如Scrapy、Beautiful Soup和Selenium,可以帮助开发者轻松获取网页数据。对于API接口,可以使用Python的Requests库来发送请求并处理响应数据。数据的存储方式也需要考虑,可以选择数据库、CSV文件或Excel等格式。

在数据爬取的过程中,合理设置爬取频率和并发请求数,以避免对目标系统造成负担。同时,做好异常处理和日志记录,以便于后期的调试和分析。最后,数据清洗和转换是必不可少的步骤,以确保所获取的数据具有良好的质量和可用性。

爬取CRM系统数据有哪些法律和伦理方面的注意事项?

在进行CRM系统数据爬取时,法律和伦理问题是不可忽视的。首先,确保获得数据的合法性是非常重要的。许多CRM系统中的数据都是用户的个人信息,未经授权的访问可能会侵犯用户隐私权。此外,遵守数据保护法规,如GDPR(通用数据保护条例)和CCPA(加州消费者隐私法),是确保合法爬取数据的必要条件。

在实施爬虫时,建议提前与数据拥有者沟通,获得其同意。透明和诚实的做法有助于建立信任关系,并减少潜在的法律风险。此外,合理使用爬取的数据,确保数据用途符合原始目的,避免将数据用于不当目的。

爬取过程中,避免对目标系统造成过大压力是另一个重要的伦理考量。过于频繁的请求可能导致系统崩溃或性能下降,这在技术上和伦理上都是不可接受的。保持适当的爬取速率和频率,能够有效降低对目标系统的影响。

如何对爬取的CRM系统数据进行分析和利用?

获取CRM系统数据后,数据分析和利用是下一步的重点。数据分析可以帮助企业洞察客户行为、优化销售策略和提升客户服务质量。首先,使用数据分析工具(如Python的Pandas、NumPy)对爬取的数据进行整理和清洗。这一步骤可以确保数据的准确性和一致性,去除重复项和异常值。

接下来,可以进行探索性数据分析(EDA),通过可视化工具(如Matplotlib、Seaborn)展示数据的趋势和模式。这些可视化图表能够帮助团队快速识别潜在的商业机会和问题。例如,通过分析客户的购买历史,可以识别出高价值客户,并制定相应的营销策略。

最终,利用数据建模技术(如机器学习算法)来预测未来的客户行为和市场趋势。通过建立预测模型,企业能够更好地制定决策,提高销售转化率和客户满意度。在整个过程中,确保数据的安全性和隐私保护,避免数据泄露和滥用。

数据的有效利用不仅能够提升企业的竞争优势,还能在行业中树立良好的品牌形象,吸引更多客户的关注和信任。

阅读时间:6 分钟

阅读时间:6 分钟  浏览量:9980次

浏览量:9980次

《零代码开发知识图谱》

《零代码开发知识图谱》

《零代码

新动能》案例集

《零代码

新动能》案例集

《企业零代码系统搭建指南》

《企业零代码系统搭建指南》