爬取CRM系统数据的常用方法包括:使用API接口、模拟用户操作、数据库直接访问。在实际操作中,最推荐的方法是使用API接口。使用API接口可以确保数据获取的合法性和高效性,同时也能减少对CRM系统的干扰。API接口通常由CRM系统提供,允许用户通过编程的方式获取系统中的数据。使用API接口的主要步骤包括:获取API访问权限、编写代码请求数据、处理和存储数据。API接口的使用不仅能够提高数据获取的效率,还能确保数据的准确性和及时性。下面将详细介绍如何使用API接口和其他方法来爬取CRM系统数据。

一、API接口

API接口是爬取CRM系统数据的首选方法。许多CRM系统如Salesforce、HubSpot等都提供了丰富的API接口,允许用户通过编程方式访问和操作系统中的数据。使用API接口爬取数据的优点在于其稳定性和合法性。具体步骤如下:

-

获取API访问权限:首先需要在CRM系统的后台管理界面中申请API访问权限,这通常需要一定的权限和认证。不同CRM系统的API权限申请流程会有所不同,用户可以参考官方文档进行操作。

-

阅读API文档:在获得API访问权限后,需要详细阅读CRM系统提供的API文档。文档中会详细介绍各类API接口的功能、参数和使用方法。这一步非常关键,因为不同的API接口有不同的调用方式和返回数据格式。

-

编写代码请求数据:根据API文档编写代码,通常使用HTTP请求的方式来调用API接口。可以使用各种编程语言和HTTP库,如Python的requests库、JavaScript的axios库等。示例如下:

import requests

url = "https://api.crm.com/v1/data"

headers = {

"Authorization": "Bearer YOUR_ACCESS_TOKEN",

"Content-Type": "application/json"

}

response = requests.get(url, headers=headers)

data = response.json()

- 处理和存储数据:获取到数据后,需要对数据进行处理和存储。可以将数据存储在数据库中,或者进行进一步的数据分析和处理。

二、模拟用户操作

模拟用户操作是另一种爬取CRM系统数据的方法,适用于没有提供API接口的CRM系统。这种方法通常使用浏览器自动化工具如Selenium来模拟用户的操作,通过登录、点击、填写表单等操作来获取数据。具体步骤如下:

- 安装和配置Selenium:首先需要安装Selenium库和对应的浏览器驱动,例如ChromeDriver。可以通过pip安装Selenium库:

pip install selenium

然后下载对应的浏览器驱动并配置环境变量。

- 编写自动化脚本:使用Selenium编写脚本来模拟用户操作,具体包括打开浏览器、登录CRM系统、导航到数据页面、抓取数据等。示例如下:

from selenium import webdriver

from selenium.webdriver.common.by import By

from selenium.webdriver.common.keys import Keys

driver = webdriver.Chrome(executable_path='path/to/chromedriver')

driver.get("https://crm.com/login")

登录操作

username = driver.find_element(By.ID, "username")

password = driver.find_element(By.ID, "password")

username.send_keys("your_username")

password.send_keys("your_password")

password.send_keys(Keys.RETURN)

导航到数据页面

driver.get("https://crm.com/data")

抓取数据

data_elements = driver.find_elements(By.CLASS_NAME, "data-class")

data = [element.text for element in data_elements]

driver.quit()

- 处理和存储数据:与API方法类似,获取到的数据需要进行处理和存储,可以存储在数据库或进行进一步分析。

三、数据库直接访问

数据库直接访问是一种高效但相对复杂的方法,适用于有数据库访问权限的场景。这种方法需要直接访问CRM系统的数据库,通过SQL查询语句获取数据。具体步骤如下:

-

获取数据库访问权限:需要有CRM系统数据库的访问权限,包括数据库地址、用户名、密码等信息。这通常需要管理员权限。

-

连接数据库:使用编程语言和数据库连接库连接到CRM系统的数据库。例如使用Python的pymysql库连接MySQL数据库:

import pymysql

connection = pymysql.connect(

host='db_host',

user='db_user',

password='db_password',

database='db_name'

)

- 执行SQL查询:编写SQL查询语句获取所需的数据。示例如下:

with connection.cursor() as cursor:

sql = "SELECT * FROM data_table"

cursor.execute(sql)

data = cursor.fetchall()

- 处理和存储数据:获取到的数据需要进行处理和存储,与前两种方法类似。

四、数据安全和隐私

在爬取CRM系统数据时,数据安全和隐私是至关重要的。无论使用哪种方法,都需要确保数据获取过程的合法性和安全性。具体措施包括:

-

遵守法律法规:确保数据获取过程符合相关法律法规,避免侵犯用户隐私和数据安全。

-

使用加密连接:在传输数据时使用加密连接(如HTTPS)来保护数据的安全性,避免数据在传输过程中被窃取。

-

定期审查权限:定期审查和更新访问权限,确保只有必要的人员和系统有数据访问权限,避免权限滥用。

-

数据脱敏处理:对敏感数据进行脱敏处理,例如对用户信息进行匿名化处理,以保护用户隐私。

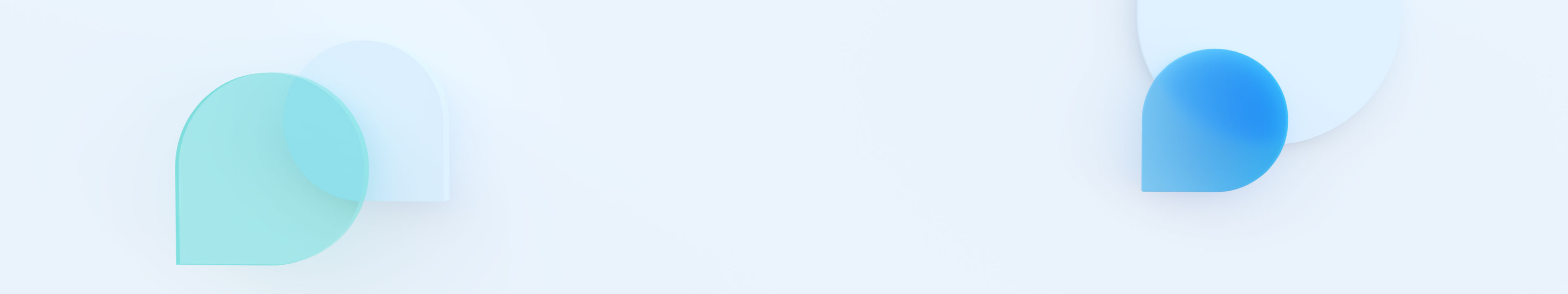

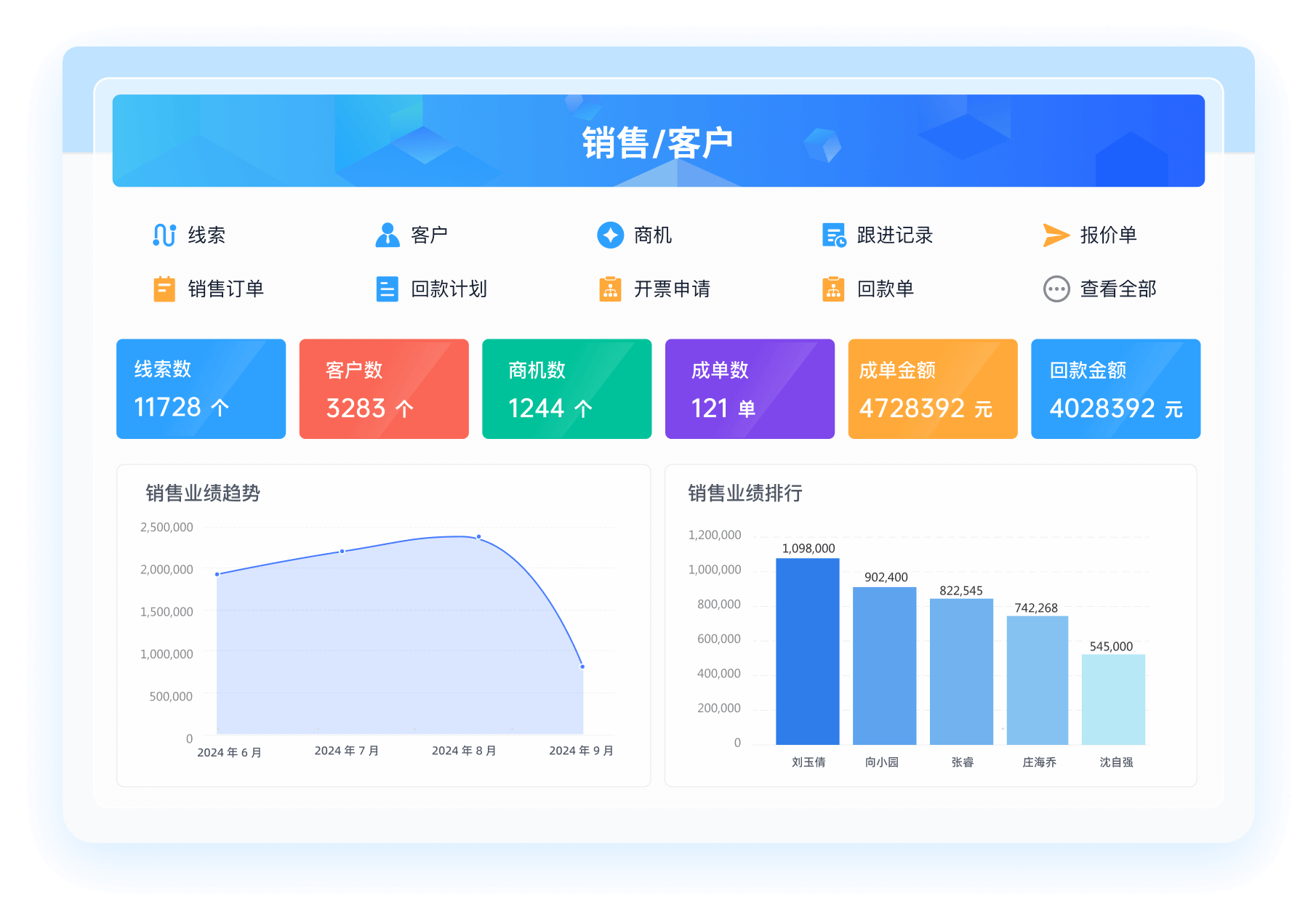

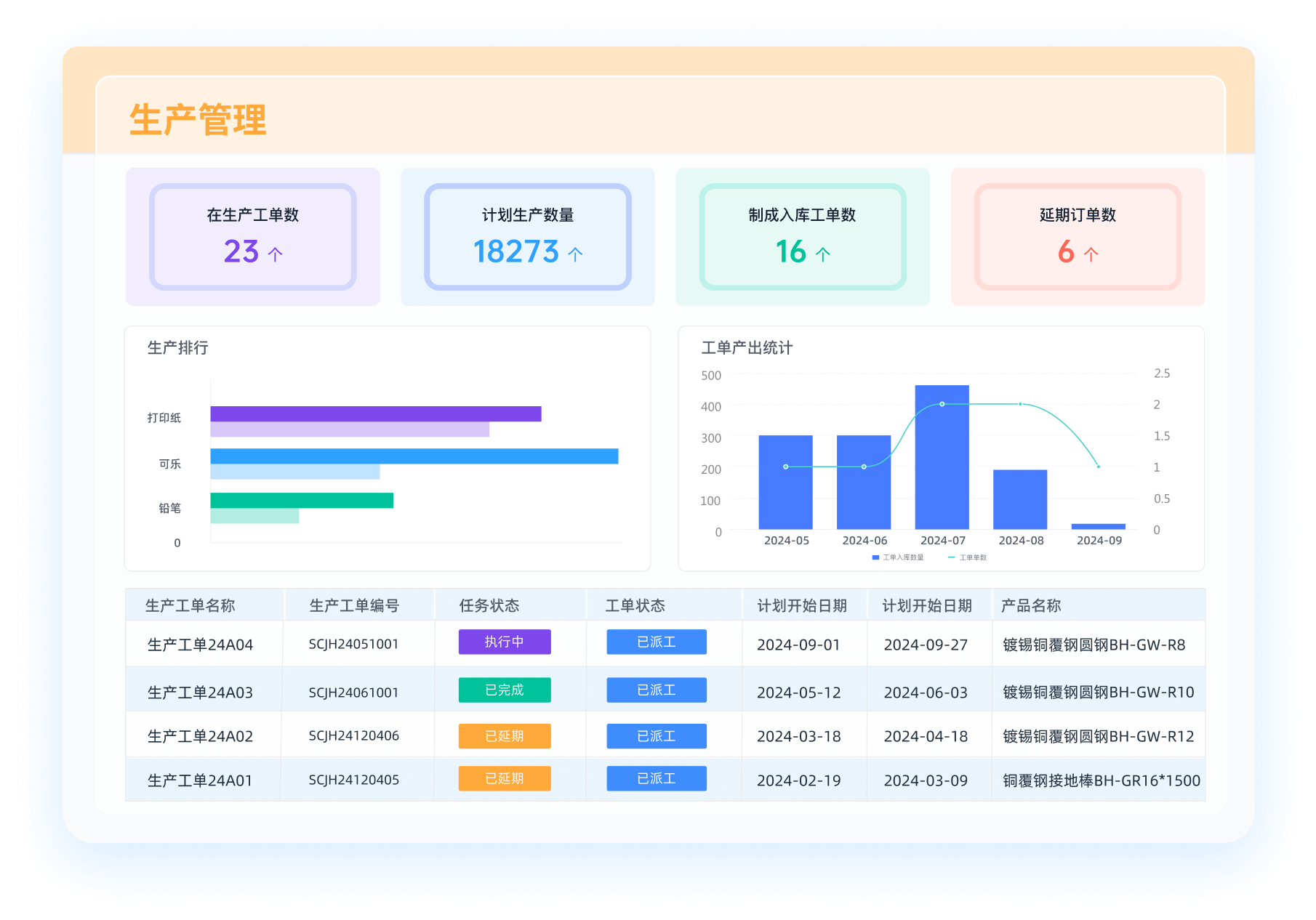

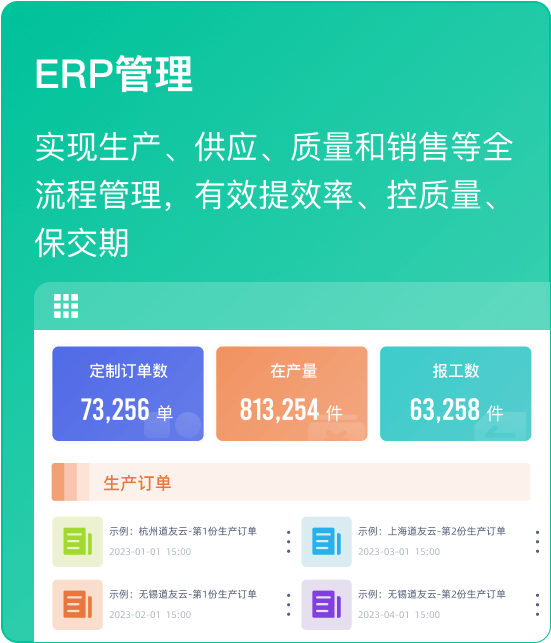

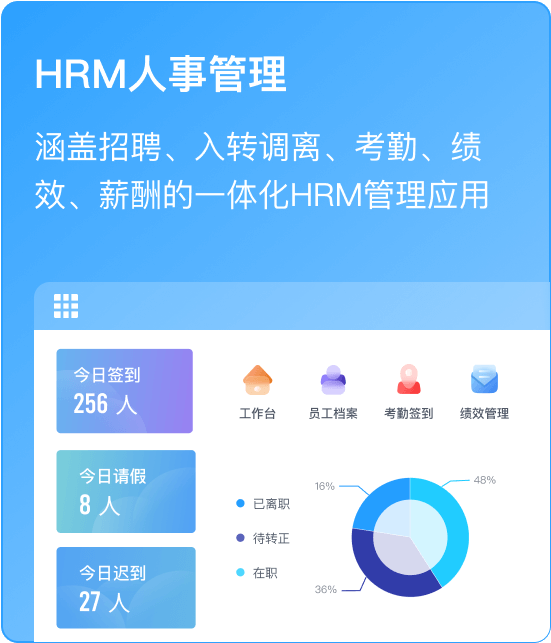

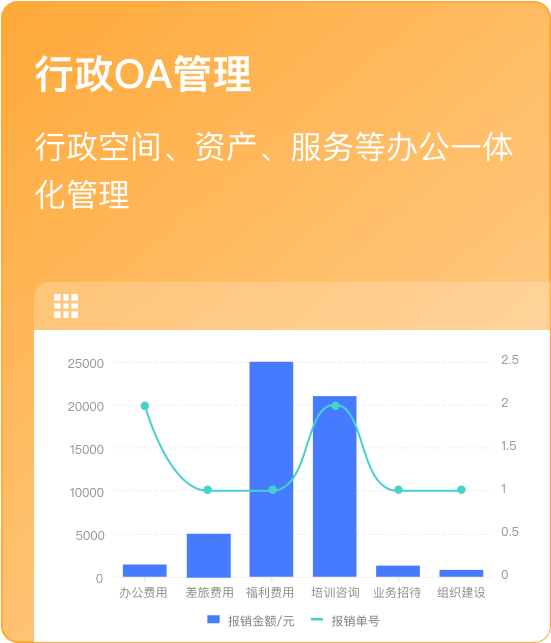

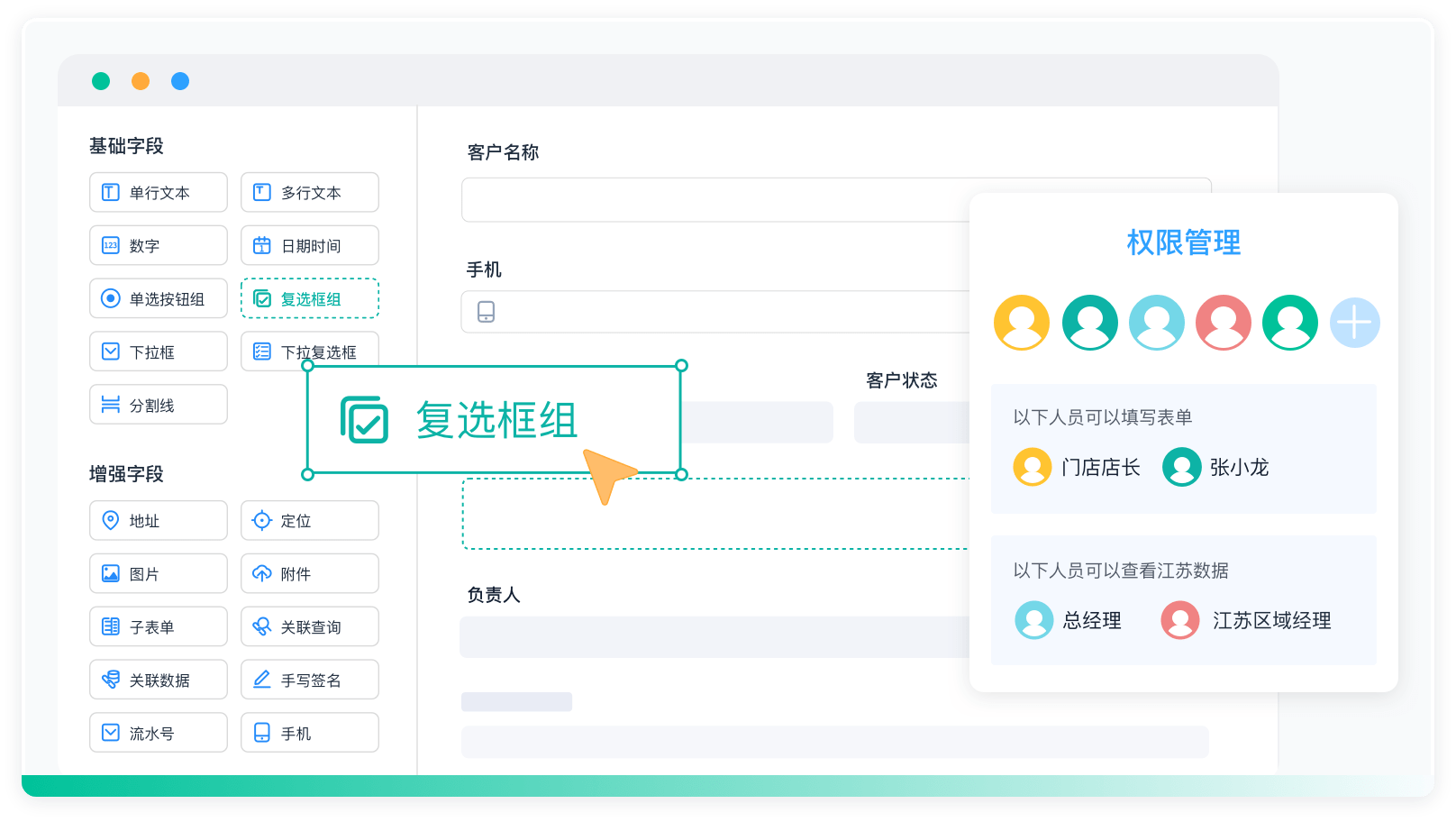

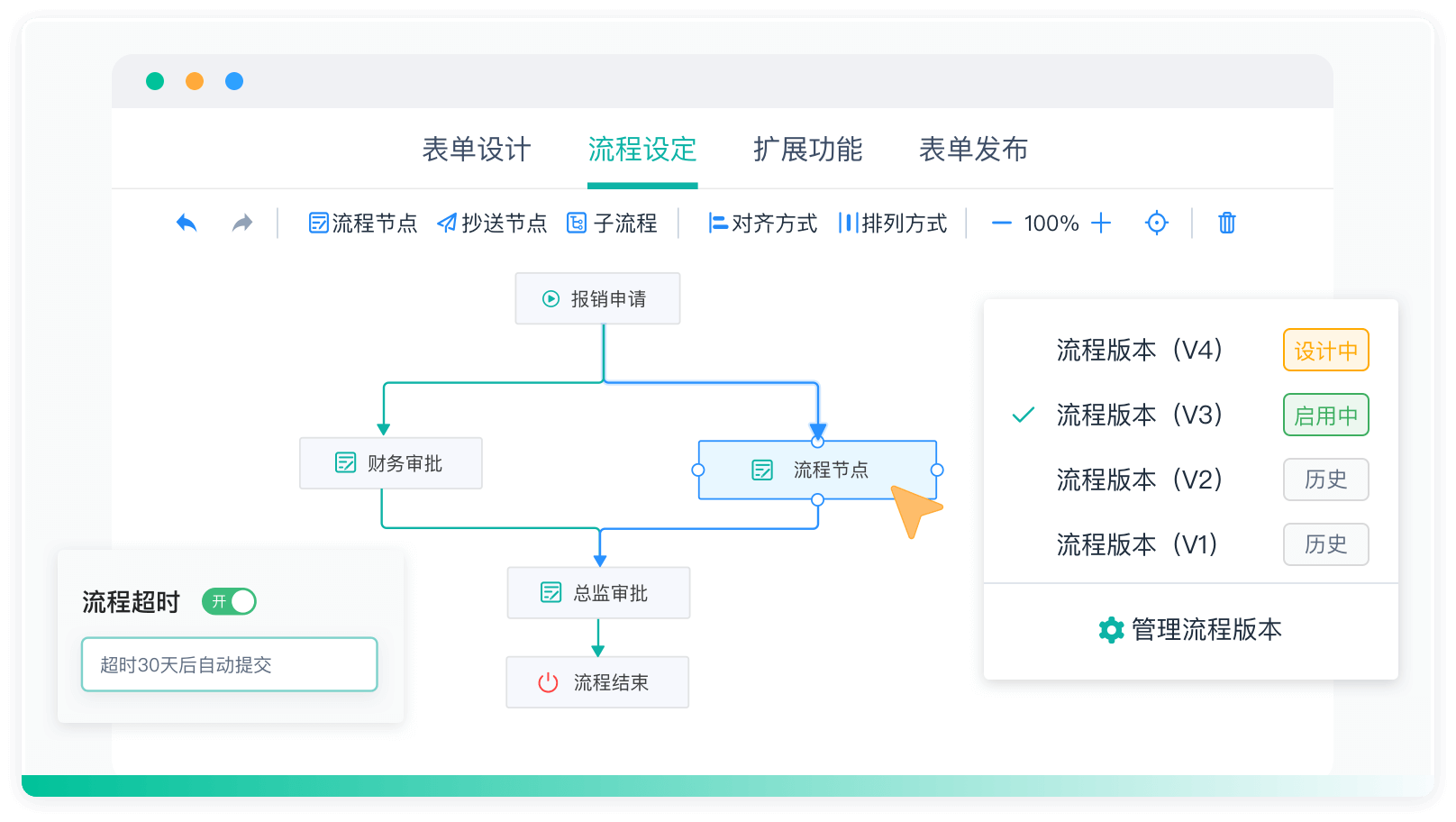

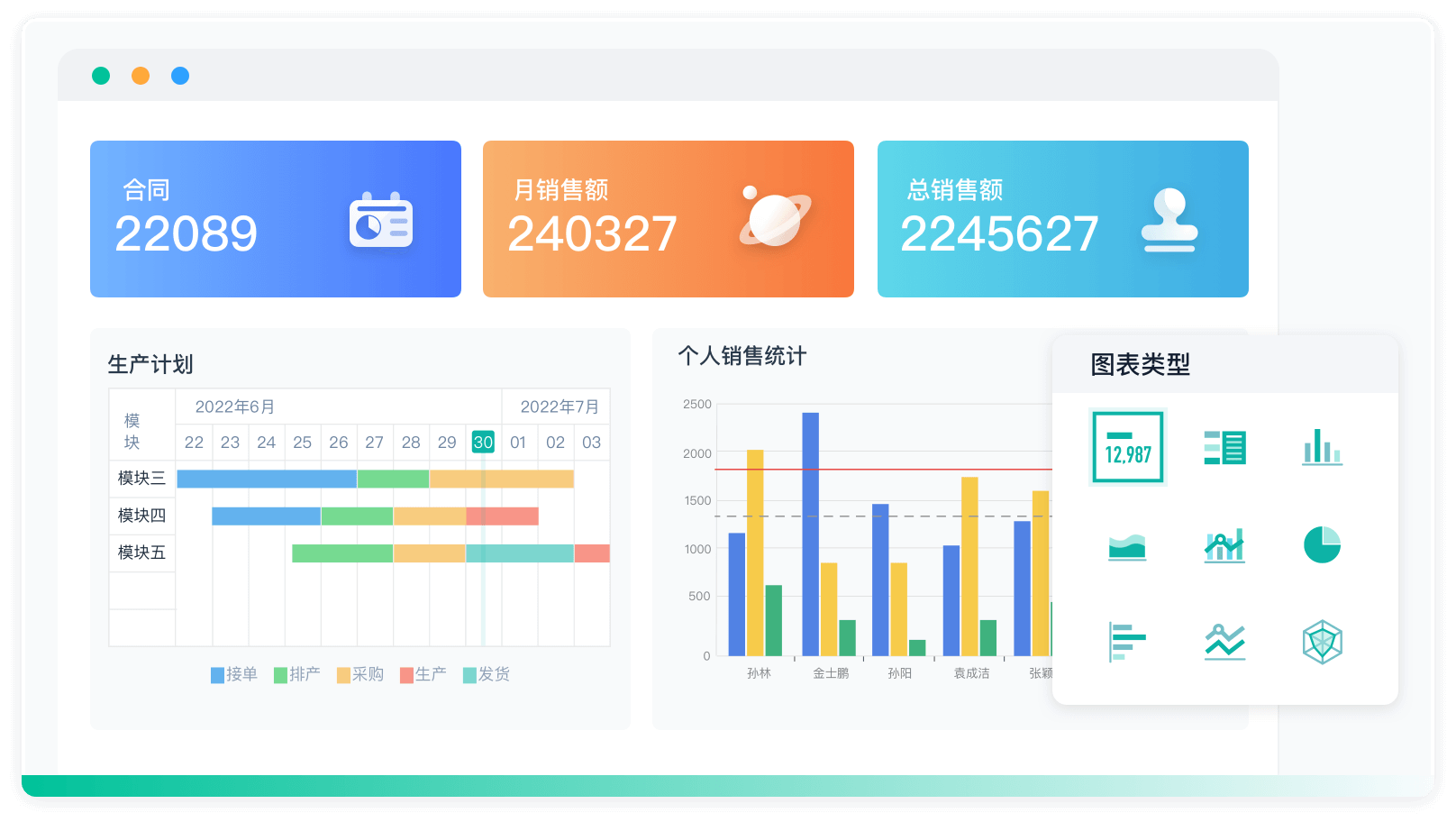

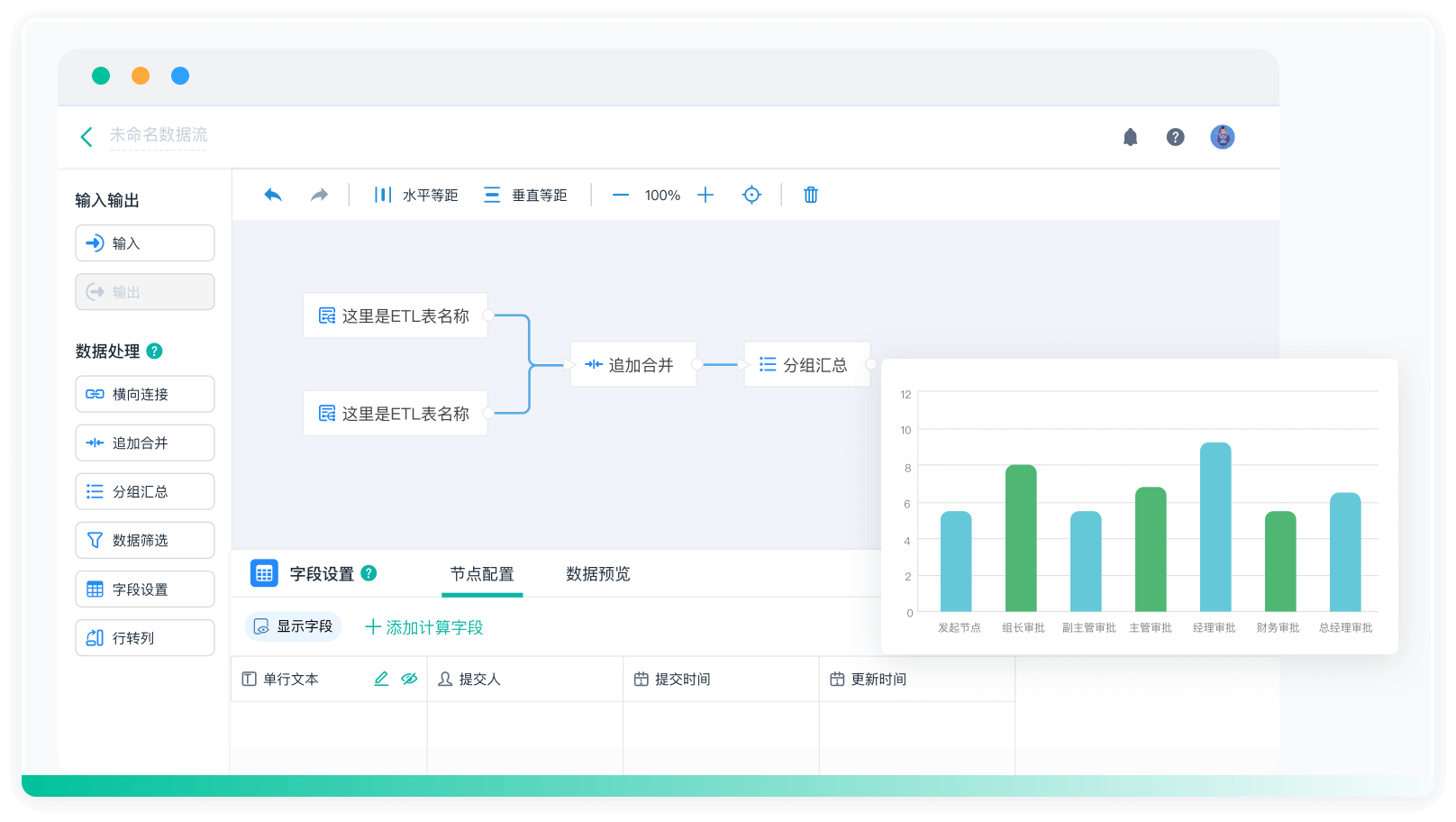

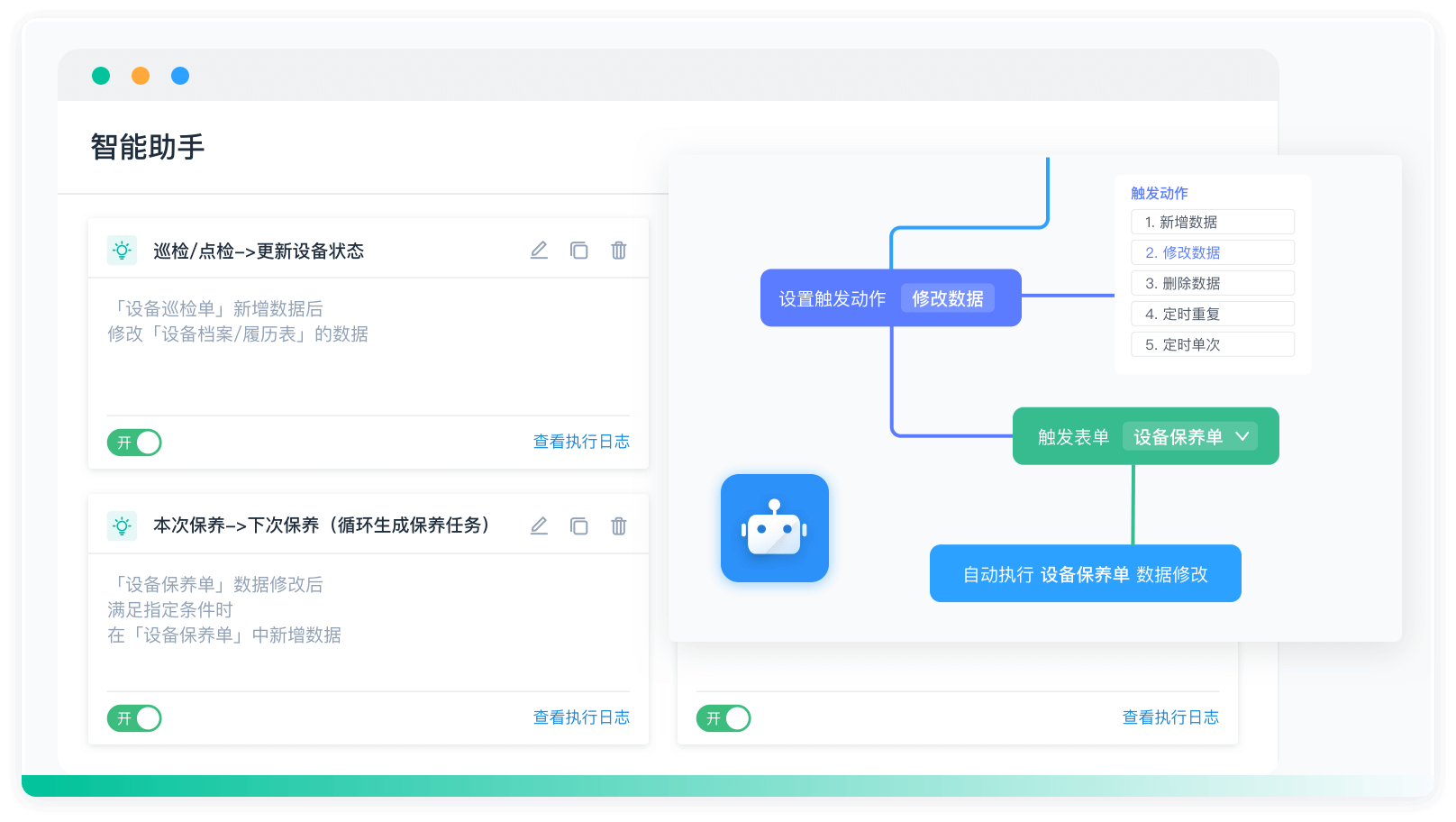

五、工具和平台

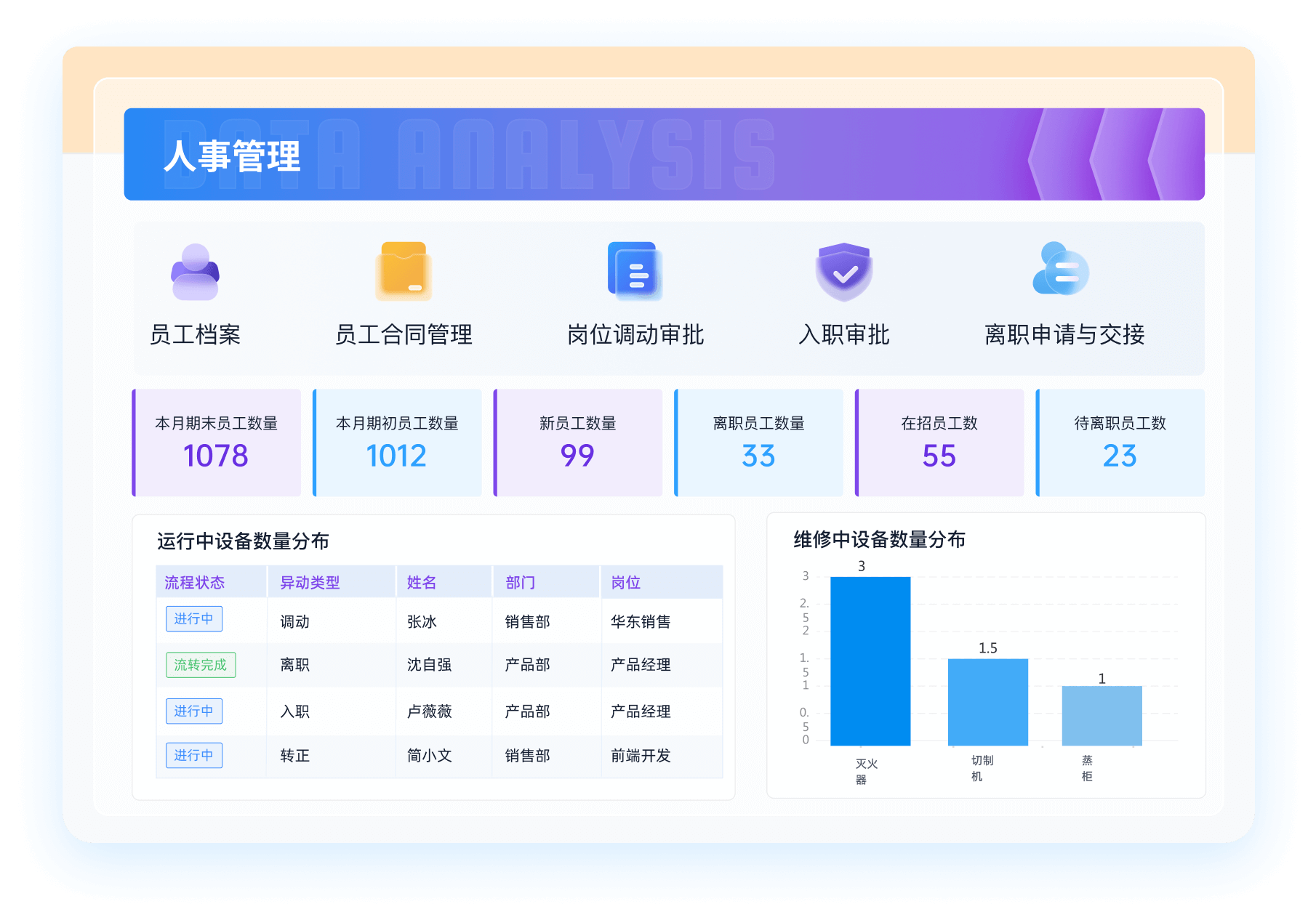

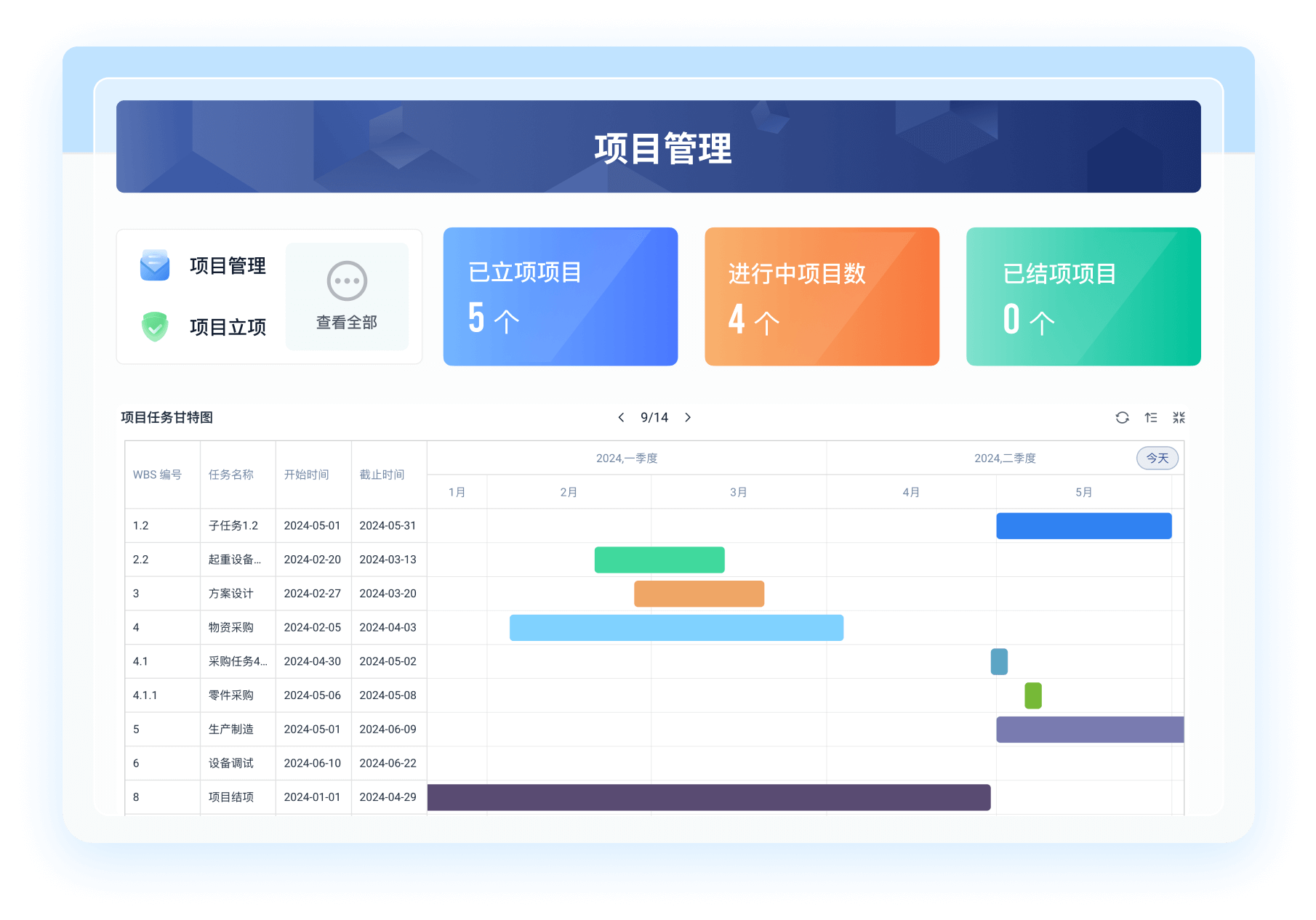

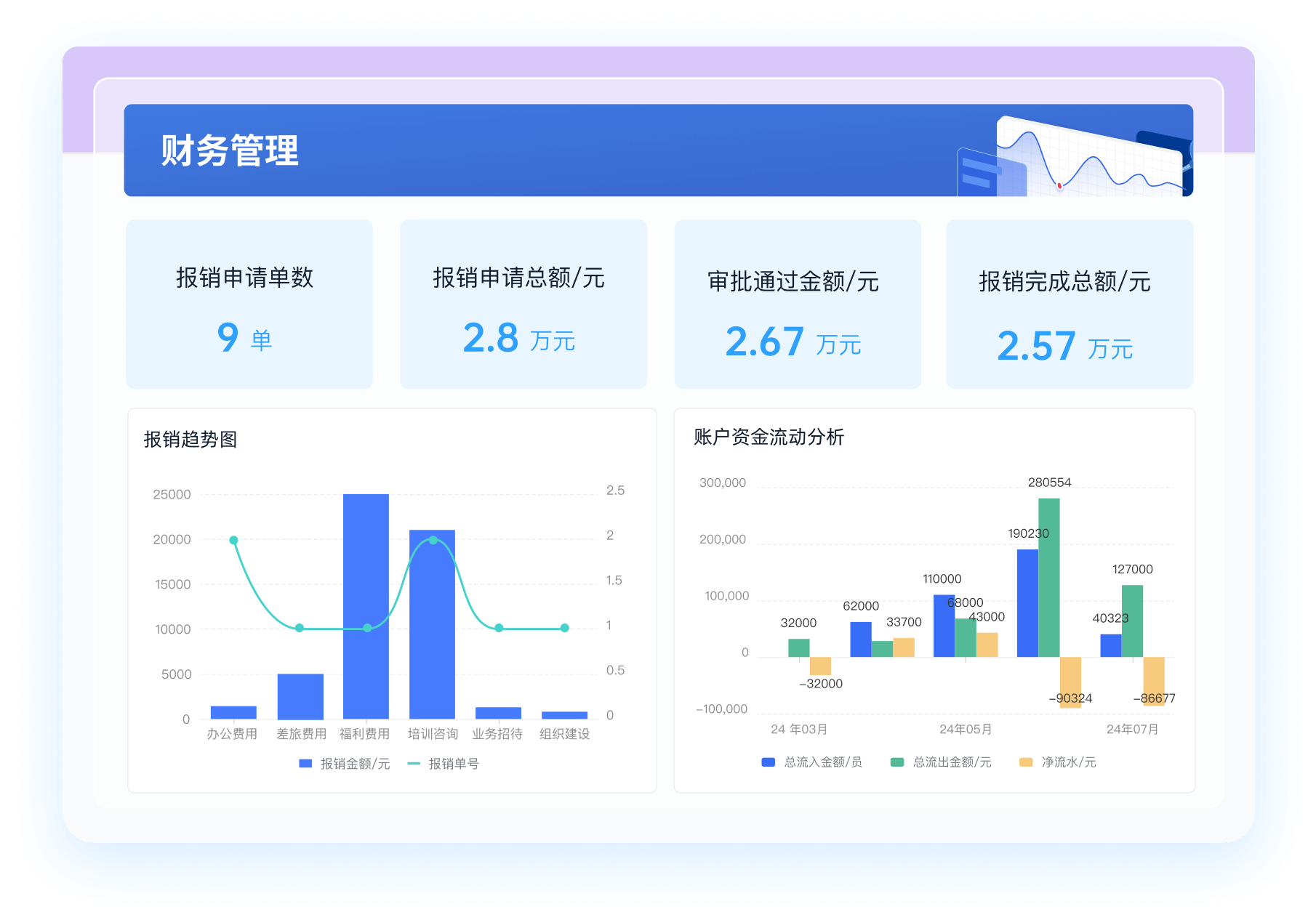

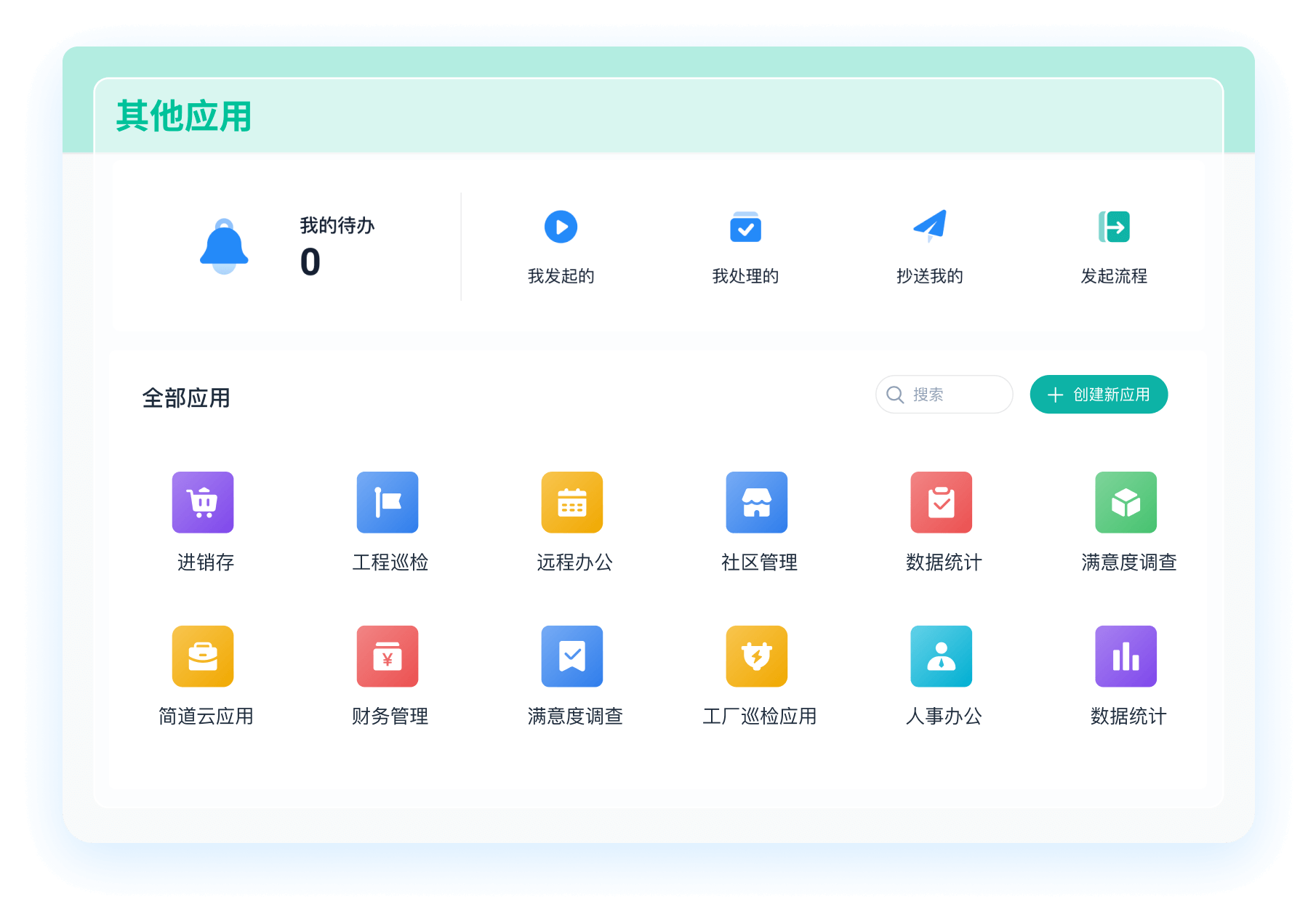

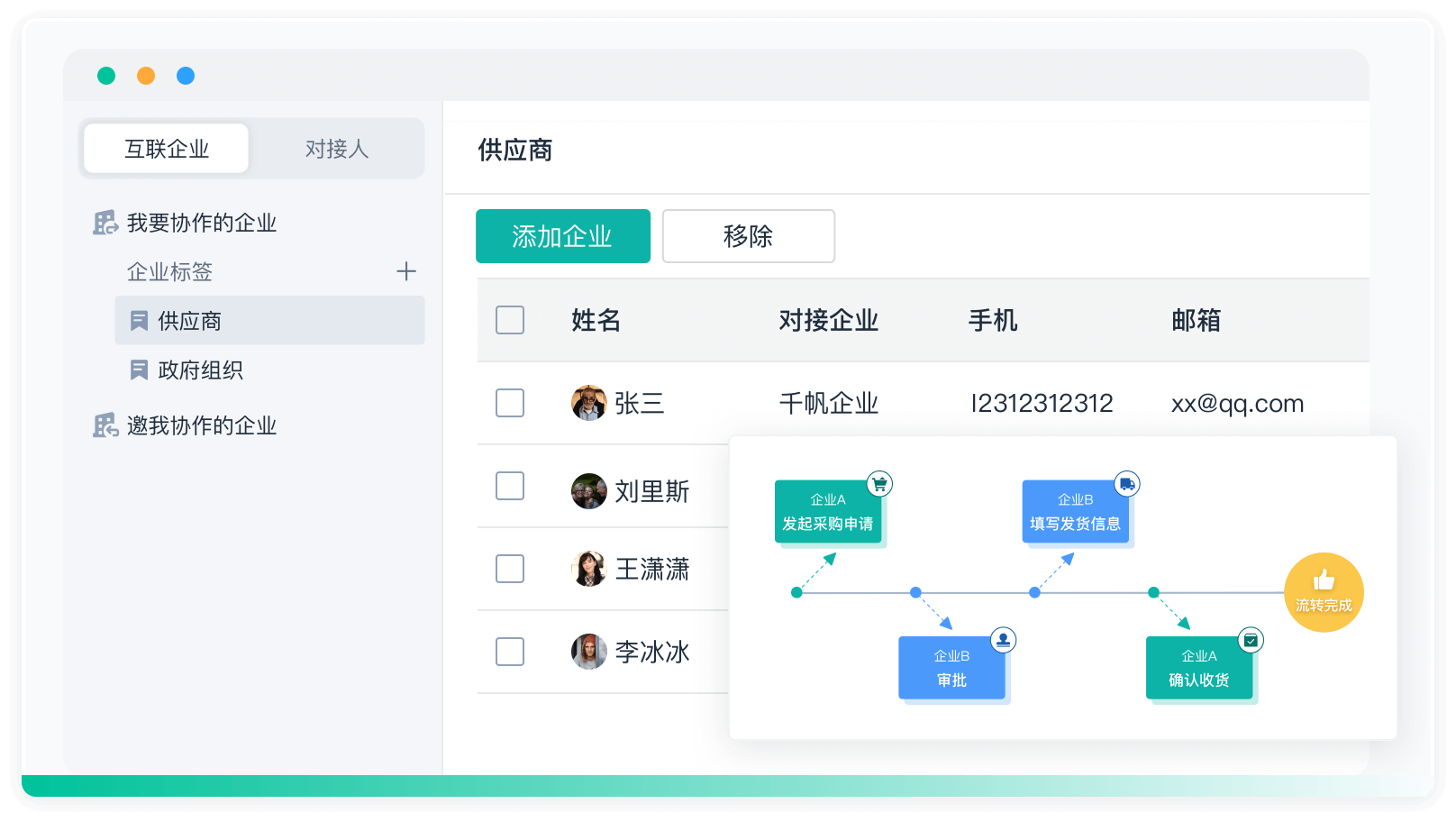

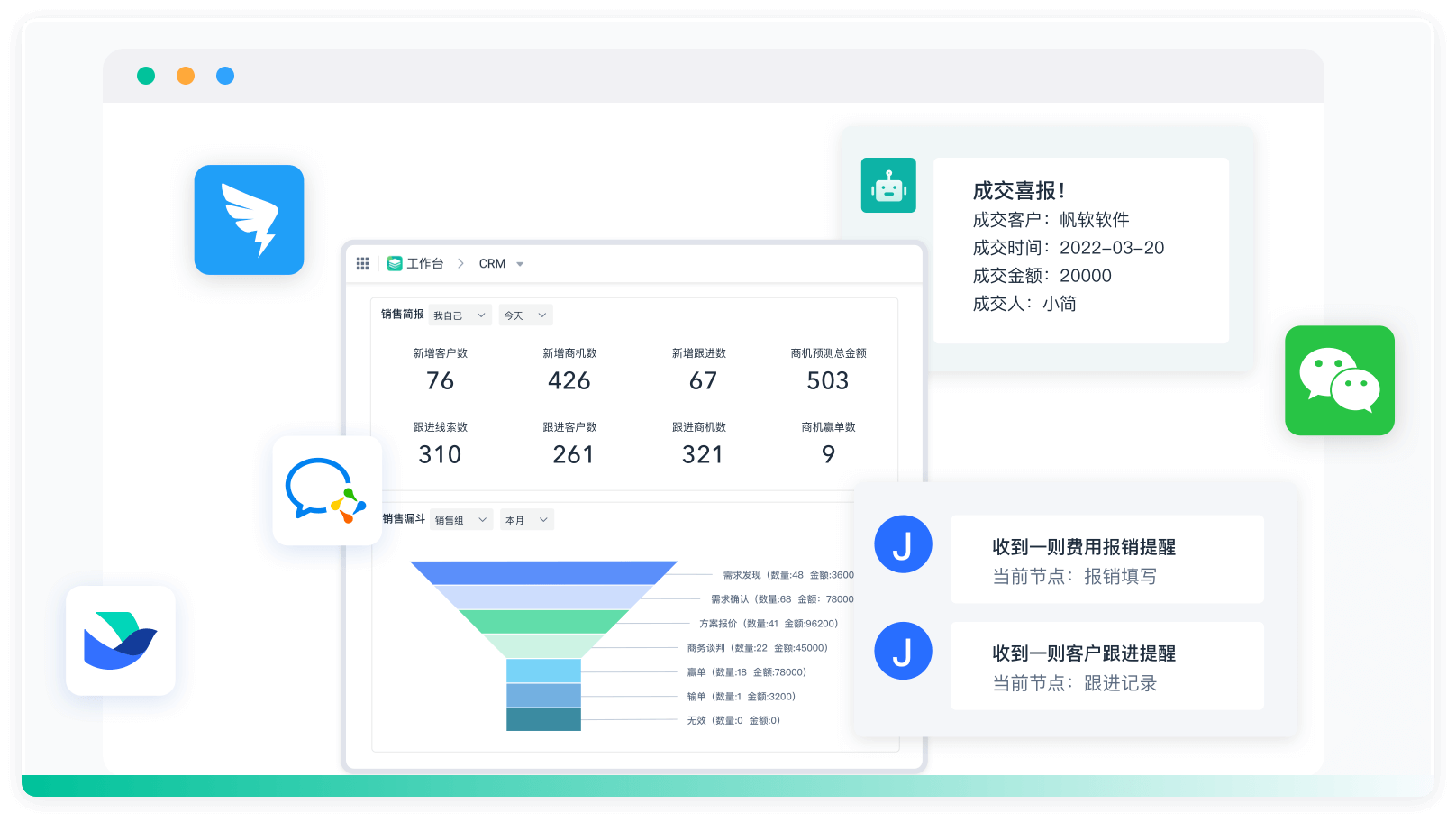

使用专业的工具和平台可以大大简化爬取CRM系统数据的过程。例如,简道云是一款强大的数据管理工具,提供了丰富的API接口和数据集成功能,可以帮助用户高效地获取和处理CRM系统数据。简道云官网: https://s.fanruan.com/6mtst;。通过简道云,用户可以轻松地集成多个数据源,进行数据分析和展示,提升工作效率。

六、实际案例分析

通过实际案例分析可以更好地理解如何爬取CRM系统数据。以下是一个使用API接口爬取Salesforce数据的案例:

-

获取API访问权限:在Salesforce后台创建一个应用程序,获取Consumer Key和Consumer Secret,用于API认证。

-

编写认证代码:使用OAuth2.0进行认证,获取Access Token。示例如下:

import requests

auth_url = "https://login.salesforce.com/services/oauth2/token"

auth_data = {

'grant_type': 'password',

'client_id': 'YOUR_CONSUMER_KEY',

'client_secret': 'YOUR_CONSUMER_SECRET',

'username': 'YOUR_USERNAME',

'password': 'YOUR_PASSWORD'

}

response = requests.post(auth_url, data=auth_data)

access_token = response.json().get('access_token')

- 请求数据:使用Access Token请求Salesforce API获取数据。示例如下:

data_url = "https://your_instance.salesforce.com/services/data/v20.0/query/?q=SELECT+name+from+Account"

headers = {

"Authorization": f"Bearer {access_token}"

}

response = requests.get(data_url, headers=headers)

data = response.json()

- 处理和存储数据:对获取到的数据进行处理和存储,可以存储在数据库或进行数据分析。

通过以上案例可以看到,使用API接口爬取CRM系统数据是一个系统化的过程,需要获取访问权限、编写代码请求数据、处理和存储数据。在实际操作中,可以根据具体需求选择最合适的方法和工具,确保数据获取的高效性和安全性。

七、常见问题及解决方案

在爬取CRM系统数据的过程中,可能会遇到一些常见问题。以下是几种常见问题及其解决方案:

-

API限流:许多CRM系统的API接口都有访问频率限制。在遇到限流问题时,可以通过优化请求频率、使用缓存等方式解决。例如,在请求频繁的数据时,可以先将数据缓存到本地,减少API请求次数。

-

数据格式不一致:不同API接口返回的数据格式可能不一致,需要对数据进行统一处理。例如,可以使用Pandas库对数据进行转换和清洗,确保数据格式一致。

-

权限不足:在获取API访问权限时,可能会遇到权限不足的问题。这时需要联系CRM系统管理员,申请必要的权限。

-

数据量大:在处理大数据量时,可能会遇到性能问题。可以通过分批次请求数据、使用多线程等方式提高数据处理效率。

-

网络问题:在请求API接口时,可能会遇到网络问题导致请求失败。可以通过设置重试机制、使用代理服务器等方式提高请求成功率。

通过以上方法和措施,可以有效解决爬取CRM系统数据过程中遇到的常见问题,提高数据获取的效率和稳定性。在实际操作中,需要根据具体情况选择合适的方法和工具,确保数据获取过程的合法性和安全性。

相关问答FAQs:

如何有效爬取CRM系统数据?

在现代商业环境中,客户关系管理(CRM)系统是企业管理客户信息和交互的重要工具。爬取CRM系统的数据可以帮助企业进行市场分析、客户行为研究等。然而,爬取数据的过程涉及技术与道德的双重考量。以下是一些有效的爬取CRM系统数据的方法和建议。

1. 选择合适的工具和技术

爬取CRM数据的第一步是选择合适的工具。市面上有多种爬虫工具和库可供选择,例如:

-

Beautiful Soup:这是一个Python库,适合处理HTML和XML文档。它能够方便地从网页中提取信息。

-

Scrapy:这是一个功能强大的Python框架,专门用于大规模爬虫项目。Scrapy支持多线程,可以提高爬取效率。

-

Selenium:如果需要与动态加载的网页交互,可以使用Selenium。它能够模拟用户的浏览行为,抓取JavaScript生成的数据。

在选择工具时,需考虑爬取的复杂性、数据量和所需的提取速度。

2. 了解目标CRM系统的结构

在进行数据爬取之前,了解目标CRM系统的结构是至关重要的。每个CRM系统都有其独特的数据库架构和API接口。可以通过以下方法获取必要的信息:

-

查看API文档:许多现代CRM系统提供API,允许开发者以结构化的方式访问数据。查阅API文档,了解如何使用API进行数据访问和操作。

-

分析网页结构:如果没有API支持,可以通过浏览器的开发者工具查看页面的HTML结构。识别需要提取的元素,例如客户信息、交易记录等。

3. 遵循道德和法律规范

在爬取数据时,遵循道德和法律规范是非常重要的。以下是一些建议:

-

遵循robots.txt:在进行爬取前,检查目标网站的robots.txt文件,确认允许爬取的页面和数据。

-

请求频率控制:设置合理的请求频率,避免对目标服务器造成过大压力。过于频繁的请求可能导致IP被封禁。

-

数据隐私保护:确保爬取的数据不会侵犯用户的隐私权。如果涉及敏感数据,提前获取相关授权。

4. 数据清洗与存储

爬取后,通常需要对数据进行清洗和存储。数据清洗的过程包括去重、格式化、填补缺失值等。可以使用Python的Pandas库进行数据处理。

数据存储方面,可以选择多种方式:

-

数据库:如MySQL、PostgreSQL等关系型数据库,适合结构化数据存储。

-

NoSQL数据库:如MongoDB等,适合存储非结构化数据。

-

CSV或Excel文件:对于小型项目,可以直接将数据存储为CSV或Excel文件,方便后续分析。

5. 数据分析与可视化

爬取并存储数据后,进行分析与可视化是必不可少的步骤。可以使用以下工具和技术:

-

数据分析:使用Python的Pandas、NumPy等库进行数据分析,提取有价值的信息。

-

数据可视化:使用Matplotlib、Seaborn等库将数据可视化,帮助企业更直观地理解客户行为和市场趋势。

6. 案例研究与应用

为了更好地理解如何爬取CRM系统数据,可以参考一些实际案例。例如,一家电子商务公司通过爬取CRM系统的数据,分析客户购买行为,优化了营销策略,最终实现了销售额的大幅增长。

7. 总结

爬取CRM系统数据是一个系统工程,涉及工具选择、结构分析、法律遵循、数据清洗和分析等多个环节。通过合理的方法和技术,企业能够有效地获取有价值的信息,提升决策水平。

推荐100+企业管理系统模板免费使用>>>无需下载,在线安装:

地址: https://s.fanruan.com/7wtn5;

阅读时间:8 分钟

阅读时间:8 分钟  浏览量:8570次

浏览量:8570次

《零代码开发知识图谱》

《零代码开发知识图谱》

《零代码

新动能》案例集

《零代码

新动能》案例集

《企业零代码系统搭建指南》

《企业零代码系统搭建指南》