srm防止过拟合什么意思

-

“SRM防止过拟合”是指在机器学习中通过结构风险最小化(Structural Risk Minimization,SRM)来防止模型过度拟合训练数据的现象。过拟合是指机器学习模型在训练数据上表现良好,但在测试数据集上表现较差的情况,表明模型对训练数据中的噪声进行了学习,无法泛化到未见过的数据。

结构风险最小化(SRM)是一种结合了经验风险最小化(Empirical Risk Minimization,ERM)和模型复杂度的方法,通过在损失函数中添加正则化项来平衡模型的预测能力和复杂度,以防止过拟合现象的发生。在机器学习中,SRM旨在选择既能够较好拟合训练数据又能够泛化到未见数据的模型。

接下来将详细介绍SRM方法如何防止过拟合,包括正则化方法、交叉验证、特征选择等方面。

1. 正则化方法

正则化是通过在损失函数中增加一个惩罚项来限制模型的复杂度,从而使模型更加简单,避免过度拟合。常见的正则化方法有L1正则化(Lasso)和L2正则化(Ridge)。

-

L1正则化通过在损失函数中加入模型权重的绝对值之和作为正则化项,可以促使模型产生稀疏解,可以自动进行特征选择。

-

L2正则化通过在损失函数中加入模型权重的平方和作为正则化项,可以减小模型参数的绝对值,有助于防止模型过拟合。

2. 交叉验证

交叉验证是一种评估模型泛化能力的方法,通过将训练数据集划分为若干个子集,在每一个子集上训练模型并在其他子集上进行验证,最终得到模型的泛化性能。常见的交叉验证方法包括K折交叉验证和留一交叉验证。

交叉验证可以有效评估模型的泛化性能,防止模型在训练数据上过拟合,同时也可以帮助选择最优的超参数,提高模型的性能。

3. 特征选择

特征选择是选择对目标变量预测有用的特征,去除无关或冗余的特征,有助于简化模型、减小模型复杂度,从而防止过拟合。常见的特征选择方法包括过滤法、包装法和嵌入法。

- 过滤法是基于特征之间的统计关系来选择特征,常用的指标包括相关系数、方差等。

- 包装法是通过训练模型进行特征选择,如递归特征消除(Recursive Feature Elimination,RFE)。

- 嵌入法是将特征选择嵌入到模型训练中,如基于正则化的特征选择方法。

4. 集成学习

集成学习通过将多个基分类器或回归器的预测结果进行结合,从而得到更好的泛化性能和抗噪能力。常见的集成学习方法包括Bagging、Boosting和随机森林。

- Bagging通过对训练数据进行自助采样,构建多个基分类器,再通过投票或平均的方式获得最终预测结果。

- Boosting通过迭代训练基分类器,并根据前一轮的预测结果调整样本权重,提升学习的困难样本。

- 随机森林是一种基于决策树构建的集成学习方法,通过随机选择特征和样本,构建多棵树并进行投票得到最终结果。

通过集成学习可以提高模型的泛化性能,减少过拟合的风险。

综上所述,SRM方法通过正则化、交叉验证、特征选择和集成学习等手段来防止模型过拟合,从而提高模型的泛化性能和稳定性,适用于各种机器学习任务和模型。

1年前 -

-

在机器学习中,SRM(Structural Risk Minimization,结构风险最小化)是一种模型选择的原则,其目的是在训练模型时不仅要考虑拟合训练数据的能力,还要考虑模型的泛化能力,以防止过拟合。

过拟合指的是模型在训练数据上表现良好,但在新的、未见过的数据上表现较差的情况。这种情况下,模型过于复杂,试图捕捉训练数据中的噪声或特定特征,而忽略了整体的模式或规律,导致泛化能力不足。为了避免过拟合,引入了SRM原则。

SRM原则通过最小化结构风险来平衡模型的复杂度和性能,以提高模型的泛化能力。结构风险由两部分组成:经验风险和置信风险。经验风险是模型在训练数据上的表现,通常用损失函数来度量;置信风险则是模型的复杂度,可以通过正则化项来表示。

在训练模型时,SRM原则会尽量选择经验风险与置信风险的和最小的模型,这样可以在保证模型拟合数据的同时,避免过度拟合。通过调整正则化参数或选择合适的模型结构,可以有效地应用SRM原则来防止过拟合。

总之,SRM原则是在机器学习中用来平衡模型复杂度和泛化能力的原则,通过最小化结构风险来选择合适的模型,以防止过拟合现象的发生。

1年前 -

SRM即结构风险最小化(Structural Risk Minimization),是机器学习中用于防止过拟合的一种模型选择原则。过拟合是指模型在训练集上表现良好,但在测试集上表现不佳的现象,通常是由于模型学习了训练集中的噪声或者特定的规律,而不是真正的一般性规律所导致的。

SRM原则的核心思想是在对模型的复杂度和训练误差之间寻求一个平衡点,以确保模型能够在未见过的数据上取得良好的泛化性能。下面是SRM帮助防止过拟合的几个关键点:

-

模型复杂度选择: SRM强调了在选择模型时要考虑模型的复杂度,避免选择过于复杂的模型。过于复杂的模型可能会在训练集上表现很好,但在测试集上容易产生过拟合现象。因此,在使用SRM原则时,需要在模型的假设空间中寻找一个对训练数据拟合较好且复杂度适中的模型。

-

正则化: 正则化是一种通过在损失函数中增加对模型复杂度的惩罚项来控制模型复杂度的方法。这样可以在训练过程中限制模型的参数大小,防止模型学习过多噪声,从而降低过拟合的风险。常见的正则化方法包括L1正则化和L2正则化。

-

交叉验证: 交叉验证是一种评估模型泛化性能的有效方法,可以在训练集上进行模型选择和调参。通过将训练集分成多个子集,在不同的子集上训练模型并在剩余的子集上验证,可以更客观地评估模型在未见过数据上的表现,有助于选择适当的模型复杂度。

-

集成学习: 集成学习是一种结合多个模型的方法,可以通过一定的策略将多个模型的预测结果进行整合,来提高模型的泛化性能。常见的集成学习方法包括bagging、boosting和随机森林等,可以减少单个模型的过拟合风险。

-

数据增强: 在数据量有限的情况下,数据增强是一种有效的方式来防止过拟合。通过对训练数据进行变换、旋转、裁剪等操作,生成新的训练样本,可以使模型学习更多的数据特征,提高泛化能力。

综上所述,SRM作为一种模型选择原则,通过考虑模型的复杂度、正则化、交叉验证、集成学习和数据增强等手段,帮助在机器学习中防止模型过拟合,提高模型的泛化性能。

1年前 -

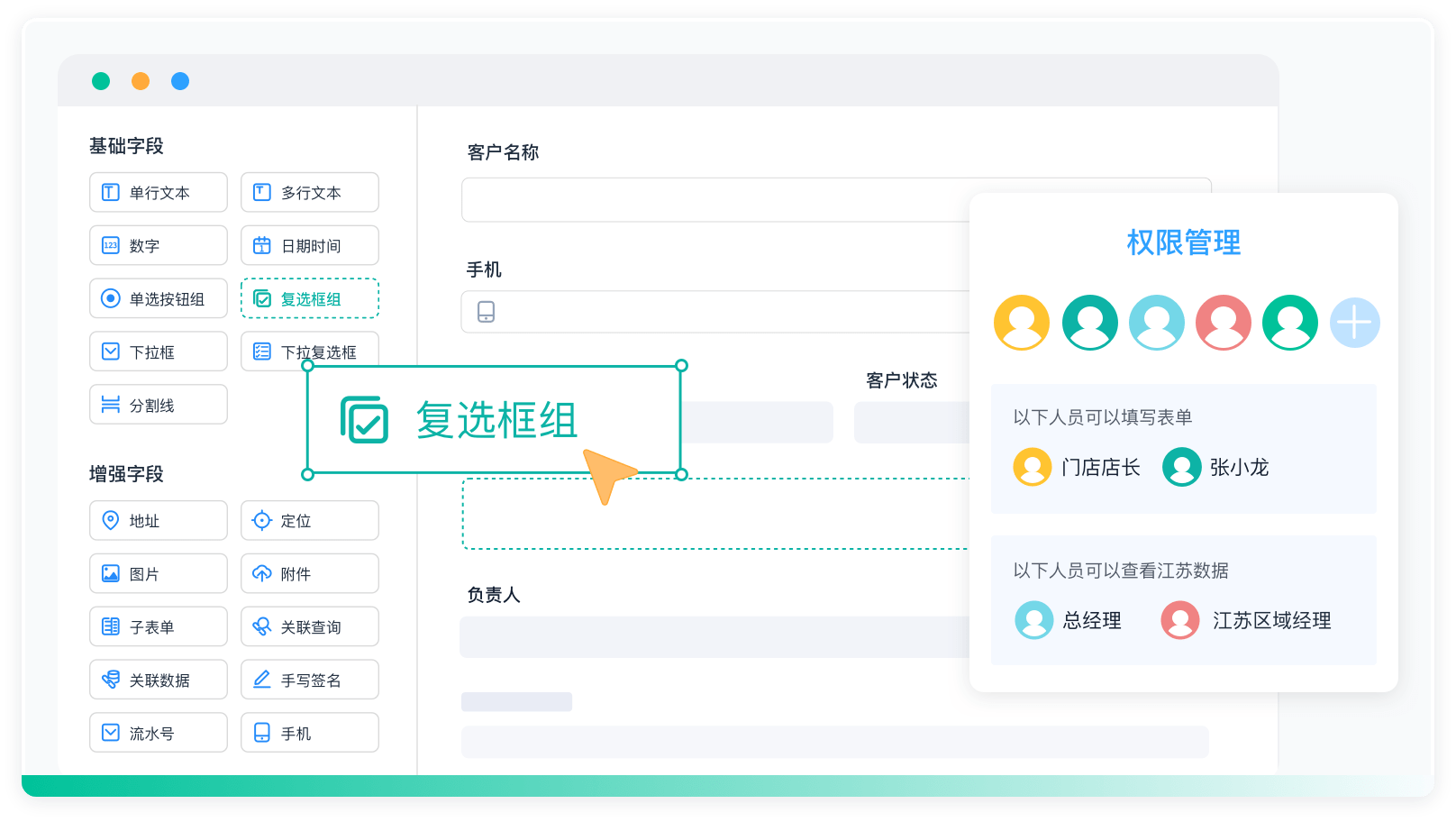

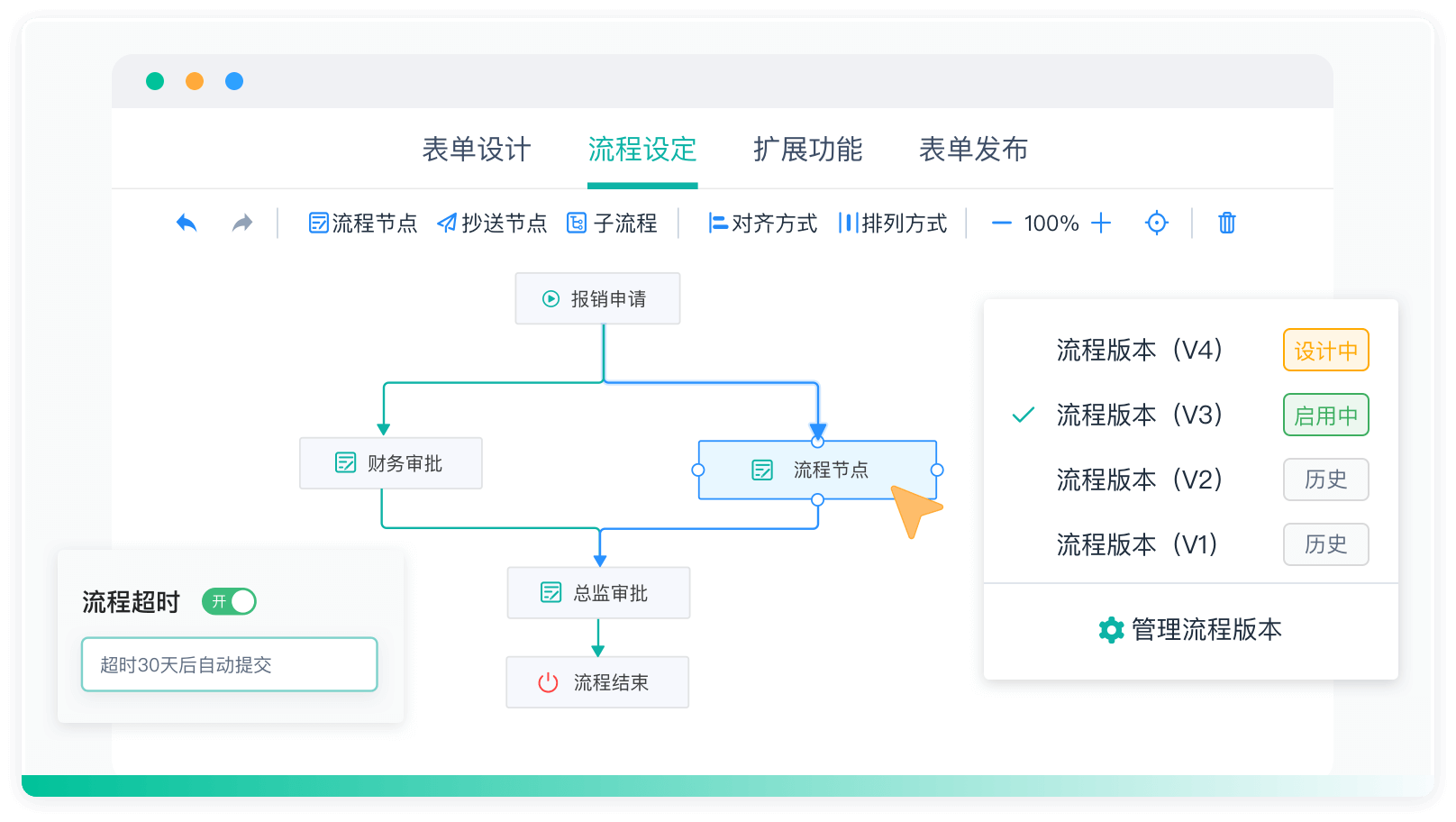

《零代码开发知识图谱》

《零代码开发知识图谱》

《零代码

新动能》案例集

《零代码

新动能》案例集

《企业零代码系统搭建指南》

《企业零代码系统搭建指南》

领先企业,真实声音

简道云让业务用户感受数字化的效果,加速数字化落地;零代码快速开发迭代提供了很低的试错成本,孵化了一批新工具新方法。

郑炯蒙牛乳业信息技术高级总监

简道云把各模块数据整合到一起,工作效率得到质的提升。现在赛艇协会遇到新的业务需求时,会直接用简道云开发demo,基本一天完成。

谭威正中国赛艇协会数据总监

业务与技术交织,让思维落地实现。四年简道云使用经历,功能越来越多也反推业务流程转变,是促使我们成长的过程。实现了真正降本增效。

袁超OPPO(苏皖)信息化部门负责人

零代码的无门槛开发方式盘活了全公司信息化推进的热情和效率,简道云打破了原先集团的数据孤岛困局,未来将继续向数据要生产力。

伍学纲东方日升新能源股份有限公司副总裁

通过简道云零代码技术的运用实践,提高了企业转型速度、减少对高技术专业人员的依赖。在应用推广上,具备员工上手快的竞争优势。

董兴潮绿城建筑科技集团信息化专业经理

简道云是目前最贴合我们实际业务的信息化产品。通过灵活的自定义平台,实现了信息互通、闭环管理,企业管理效率真正得到了提升。

王磊克吕士科学仪器(上海)有限公司总经理